Préface de la troisième édition

Écrire un bouquin pour un éditeur est un travail épuisant. La rédaction elle-même n’est qu’une toute petite partie du travail, déjà prenante, et il faut y ajouter les relations éditeur par email et la phase de relecture puis de mise en page, sans parler des questions des équipes marketing pour la promotion du livre.

Pour la première édition de ce livre, je découvrais le monde de l’édition et j’étais super motivé. Nous avons nous-mêmes choisi nos relecteurs dans la communauté Maven francophone et utilisé un DropBox, nettement plus pratique que le process d’envoi des chapitres par email proposé par l’éditeur.

Il a fallu aussi s’adapter au template Word de Pearson, qui s’est avéré pas si mal fait que ça après avoir été confronté à celui d’autres éditeurs ! Finalement, la masse de travail, toutes les tâches non prévues, pour quelques euros récoltés (8% à se partager) n’est pas du tout rentable. Si cela restait du plaisir - après tout, écrire du code OSS n’est pas très rentable non plus - la pilule pourrait passer, mais en plus il faut subir les contraintes de la chaîne d’édition.

Pearson nous a annoncé début décembre 2013 que le livre serait arrêté, faute de rentabilité. Pas vraiment une surprise, un livre technique, qui plus est en Français, n’a pas un auditoire énorme - ou alors, peut être que tout le monde fait du gradle aujourd’hui - en tout cas nous en avons vendu environ 2000 exemplaires, ce qui est un beau succès pour un marché aussi limité.

Aussi, après avoir récupéré nos droits sur le texte nous avons décidé de le convertir en AsciiDoc pour ne plus subir Word et le template editeur, et surtout de l’open-sourcer, sous licence Creative Commons 4.0 afin que tout le monde en profite et que d’éventuels contributeurs puissent nous aider à corriger les boulettes inévitables qui s’y sont glissées.

«Attribution - Pas d’Utilisation Commerciale - Partage dans les Mêmes Conditions»

«Attribution - Pas d’Utilisation Commerciale - Partage dans les Mêmes Conditions»

Nicolas de Loof

Préface de la seconde édition

La rédaction de la première édition d’Apache Maven a été un exercice difficile mais très enrichissant. Avec Arnaud, nous avons trouvé un rythme et un ton qui nous permettait de prendre du plaisir sans accumuler trop de retard - un petit mois à peine - sur le planning de Pearson. Nous en avons retiré une grande fierté, surtout avec le très bon accueil du public.

Malgré cela, nous avons rapidement identifié des manques et des sujets que nous aurions aimé approfondir. Au cours de la rédaction, les nouvelles versions de plugins et l’avancement des développements de Maven 3 rendaient certaines de nos remarques obsolètes ou moins pertinentes. La liste des éléments de notre Erratum, que nous n’avons jamais publiée d’ailleurs faute de l’organiser correctement, a commencé à s’allonger. Il était hors de question d’en rester là !

À l’heure où nous reprenons la plume (enfin, le clavier), Maven 3 enfin sorti en version 3.0 finale, est pleinement utilisable sur un projet. Les versions suivantes apporteront encore de nouvelles fonctionnalités et améliorations. Dans le même temps, de nombreux projets vont continuer d’utiliser Maven 2 pendant encore un long moment. Il n’est pas question de laisser ces utilisateurs sur le carreau juste parce que la nouvelle version de Maven est plus belle, plus grande, plus forte.

Nous avons donc choisi de donner à cette seconde édition une double lecture : le corps du texte a été revu pour correspondre à l’état de l’art, à savoir Maven 3. De nouveaux chapitres viennent en décrire les avancées et les outils associés. C’est seulement lorsqu’une rupture significative avec les versions précédentes existe que nous ajoutons un encart. Ces encarts sont reconnaissables au logo :

Vous constaterez rapidement qu’ils sont assez peu nombreux : Maven 3 est avant tout conçu pour remplacer son prédécesseur sans heurts. Même avec ces réserves, les grandes idées présentées dans le livre sont applicables aux deux versions. Nous espérons donc que vous en tirerez le meilleur parti.

Quoi qu’il en soit, nous avons utilisé Maven 3.0 dans ses diverses préversions et nous vous encourageons à migrer vers cette nouvelle édition de l’outil phare du développement Java. Les prochaines versions sont une large promesse de fonctionnalités innovantes, et « au pire » vous bénéficierez d’une amélioration des performances et d’une réduction d’occupation mémoire ! Si vous utiliser m2eclipse pour intégrer votre projet Maven dans Eclipse, vous êtes déjà des utilisateurs de Maven 3 sans même le savoir, alors laissez vos dernières hésitations de côté et en avant toute.

Nous espérons que les pages qui suivent vous aideront à prendre en main Maven et à en comprendre la richesse et la philosophie, qui en font un outil sans équivalent.

Avant-propos

L’écriture d’un ouvrage technique n’est pas une tâche triviale, car il est facile de perdre le lecteur dans une avalanche de concepts théoriques ou de s’égarer dans des détails non fondamentaux. Décrire un outil comme Maven, ou tout simplement le définir clairement, tout en restant accessible à tous, est encore plus délicat : soit on reste trop vague, et le lecteur n’a plus qu’à attendre le Chapitre 5 pour commencer à apprendre quelque chose de concret, soit on s’embarque dans de longues explications de principes et de concepts et le lecteur n’attendra jamais ce même Chapitre 5.

Pour être honnête, je dois dire que les premières ébauches de cet ouvrage sont immanquablement tombées dans ces travers, ce qui annonçait un livre bien peu pertinent pour les utilisateurs, qu’ils soient novices ou déjà expérimentés. Lorsque j’ai soumis les premiers extraits de ce projet à Arnaud, il m’en a rapidement fait la remarque et nous nous sommes accordés sur la forme que nous voulions donner à ce livre.

Mon objectif est de communiquer ma passion autour de ce projet Open Source qu’est Maven, lequel réunit des développeurs aux parcours très différents. Les rencontres que j’ai faites dans cette communauté ont forgé mon approche de l’informatique. Avec cette motivation, établir un dictionnaire impersonnel Maven-Français était exclu ; aussi j’ai rapidement choisi, en accord avec Arnaud, de privilégier une approche aussi didactique que possible, bâtie sur des exemples concrets issus de ma propre expérience du terrain.

Il est difficile de sensibiliser les utilisateurs aux enjeux que Maven tente de gérer, alors qu’ils y sont pourtant confrontés en permanence. Situation intéressante où tout le monde rencontre un problème, mais, faute de mettre un nom dessus et d’en évaluer l’importance, celui-ci reste latent tout au long de la vie du projet, amenant parfois à des situations critiques. Nous allons suivre ensemble la vie d’un projet fictif, bien que largement inspiré de situations réelles. Il passera par toutes les phases, du prototype écrit sur un coin de table à l’application stratégique d’entreprise de grande envergure, ce qui nous permettra de couvrir un très large éventail de situations.

Plutôt que de décrire le rôle de Maven sur un projet, ou de vous accabler par un long exposé théorique sur ses concepts, je préfère au travers de cette démonstration un peu romancée vous montrer les difficultés concrètes auxquelles Maven s’attaque. Sur la base de ces exemples, parfois volontairement excessifs, je souhaite vous démontrer de manière ludique les avantages que Maven peut apporter à vos projets. Malgré les caricatures proposées, de nombreuses situations vous sembleront familières. Derrière la fiction se cachent des cas bien réels, que je n’ai fait qu’amplifier, et beaucoup auront des points communs avec vos propres difficultés. Ce parallèle vous donnera une image réaliste de Maven et des conseils applicables dans les meilleurs délais.

J’espère que vous apprécierez ce choix et que vous tirerez un enseignement pratique du texte qui suit. En particulier, j’aimerais qu’arrivé au bout de votre lecture vous soyez conscient des objectifs visés par Maven, de sa philosophie et des raisons pour lesquelles il devient un élément clé de la boîte à outils du développeur. Enfin, je souhaite réussir à vous transmettre mon enthousiasme pour ce projet libre, auquel vous pouvez participer en rejoignant le forum pour y exposer vos interrogations, apporter de nouvelles idées, proposer des contributions de toutes sortes et participer à l’amélioration générale de cet outil. Arnaud et moi avons commencé de cette façon avant de passer « de l’autre côté du miroir », mais au quotidien nous restons comme vous, avant tout, des utilisateurs de Maven, soucieux de disposer d’un outil pertinent et productif.

Nicolas de Loof

Lorsque Nicolas m’a contacté pour écrire un ouvrage sur Maven en français, j’ai commencé par me demander si cela en valait la peine. Certes, la documentation du produit est critiquable. Elle est très dispersée, et il est souvent difficile de trouver l’information utile lorsqu’on ne sait pas où la chercher entre le site web du projet [1], ses nombreux plugins et son wiki [2]. Pourtant, il existe désormais deux ouvrages en anglais disponibles gratuitement sur la Toile pour combler ces manques : Better Builds with Maven [3], publié en 2006, et Maven : The Definitive Guide [4], publié en 2007 et régulièrement mis à jour. Alors qu’apporter de plus qu’une simple traduction en français de ces ouvrages ?

Après de nombreuses années à utiliser et à préconiser Maven dans des contextes variés, j’avais envie de partager tout ce que j’avais pu emmagasiner comme bonnes pratiques et pointer sur les mauvaises que j’avais pu rencontrer. C’est sur ce principe que nous avons commencé avec Nicolas à bâtir le squelette de cet ouvrage. Fondé sur un projet fictif, il retrace nos expériences ainsi que celles des personnes que nous avions croisées sur notre chemin et permet d’expliquer les enjeux de Maven dans un projet et dans une entreprise. Même si nous n’avons pas recherché l’exhaustivité dans les cas traités, tellement ils peuvent être nombreux, nous avons essayé de faire apparaître les plus fréquents ou les plus épineux que nous ayons eus à résoudre. Nous avons axé nos efforts sur la présentation et la compréhension des concepts plutôt que sur le détail du paramétrage, lequel peut évoluer périodiquement.

J’espère que cet ouvrage saura autant vous divertir que vous former sur cet outil complet afin qu’il ne soit plus jamais complexe à vos yeux.

Arnaud Héritier

Contenu

Cet ouvrage se compose de quatre parties :

-

La première, du Chapitre 1 au Chapitre 5, aborde les concepts fondamentaux de Maven et leur mise en œuvre pratique. Nous avons choisi de mettre en scène de manière très explicite et souvent exagérée les problèmes que Maven tente de prendre en charge, afin que cette première partie soit aussi didactique que possible.

-

La deuxième, du Chapitre 6 au Chapitre 10, exploite des fonctionnalités plus avancées de Maven pour traiter des besoins orientés « gros projets d’entreprise » mais tout aussi délicats. Cette partie s’adresse typiquement aux développeurs intervenant sur des projets JavaEE (Java Enterprise Edition) en entreprise.

-

La troisième regroupe les Chapitres 11 à 15 et couvre des facettes plus spécialisées et moins mises en avant de Maven, mais que nous considérons comme tout aussi essentielles. Vous verrez alors que Maven ne se résume pas comme on le lit souvent à « un outil de compilation ».

-

Pour terminer cet ouvrage le Chapitre 16 sera l’occasion de résumer les éléments clés présentés, de vous donner nos recommandations, bonnes et mauvaises pratiques à connaître pour tirer le meilleur de Maven. Par ailleurs, nous nous essayerons à l’exercice acrobatique de la boule de cristal en vous présentant l’avenir du projet Maven. Nous indiquerons comment aller au-delà de ce livre en participant à la communauté qui épaule ce projet Open Source. Le Chapitre 17 conclura le récit de notre histoire et vous présentera les personnes qui nous ont inspiré les différents protagonistes.

Un dix-huitième chapitre vous propose un lexique qui éclaircit les mots quelque peu abscons utilisés dans cet ouvrage.

Partie 1

Premiers pas avec Maven

Chapitre 1 : Introduction

Commençons donc notre récit par l’inévitable mise en garde : toute ressemblance avec des personnes ou des situations existantes ou ayant existé ne serait que fortuite…

Prologue

Nicolas et Arnaud se sont rencontrés au cours d’une conférence organisée par un Java User Group (si vous ne participez pas à un JUG … et bien vous avez tort). Faisant connaissance autour d’un verre, ils évoquent les souvenirs de leurs premiers pas avec Java, devenu depuis leur plateforme de prédilection. Un Java Development Kit dans une version qui fait sourire aujourd’hui, et les bons vieux « Hello World » qui initient tout développeur à un nouveau langage. De nombreux souvenirs qui rappellent qu’on a tous débuté un jour, rencontré les mêmes problèmes et commis les mêmes erreurs idiotes que l’on dénonce aujourd’hui.

La première application un peu intéressante de Nicolas était un splendide outil de gestion de sa liste de courses. D’un naturel assez désorganisé, Nicolas n’a jamais réussi à mémoriser toute la liste. Il lui est même déjà arrivé de l’oublier ou pire, d’oublier tout simplement de faire les courses. Son application était donc un extraordinaire pense-bête, qu’il lançait à l’avance et qui lui envoyait fièrement, dix minutes avant son départ du bureau, un message de rappel avec la liste des courses. Autrement dit, un outil de rêve totalement indispensable, à tel point que le code de ce monument de l’informatique est respectueusement conservé quelque part.

Arnaud, confronté au même souci et amusé par cette solution de pur geek, lui demande s’il a toujours son programme et s’il peut en faire une copie pour satisfaire sa curiosité – la geekitude est dangereusement contagieuse !

Partageons !

De retour à la maison, Nicolas fouille dans ses archives et en retire une vieille disquette (vous savez, ces carrés de plastique qu’on utilisait « dans le temps », avant que la clé USB et Internet ne les fassent disparaître). Il envoie donc le trésor tant convoité à Arnaud.

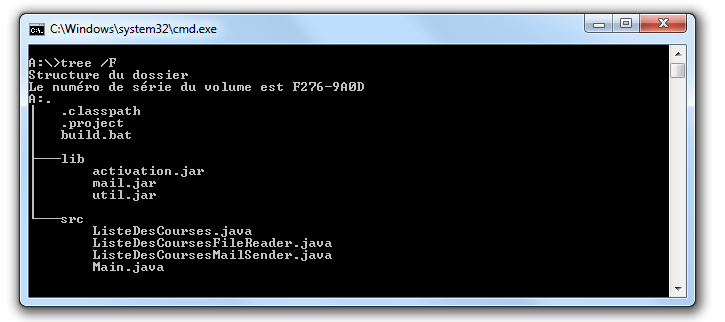

Pour vous faire une meilleure idée de cette exceptionnelle construction logicielle, voici les fichiers qui la constituent :

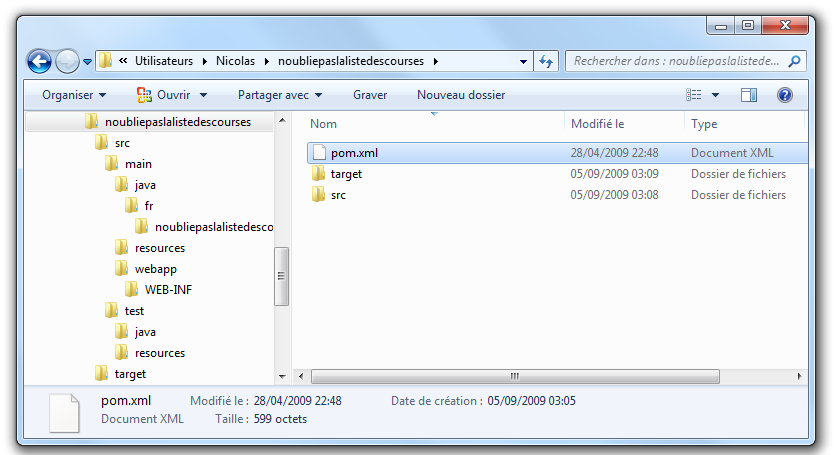

La structure originale du projet « noubliepaslalistedescourses ».

Arnaud, qui, semble-t-il, n’a vraiment que cela à faire de son temps libre, se jette sur cette magnifique relique des années Java 1.1 et tente de le compiler. Seulement, Arnaud est un utilisateur Mac. Le fichier BAT qui compile et assemble le logiciel en une archive Java JAR est inexploitable sur son système. Arnaud n’est pas du genre à se décourager si facilement, aussi écrit-il un fichier de compilation adapté à son environnement afin de pouvoir tester ce chef-d’œuvre de l’informatique.

Deux jours plus tard, profitant d’un peu de rangement, Nicolas retrouve une autre disquette contenant une version plus avancée de son logiciel, qui utilise les fonctions d’une bibliothèque utilitaire pour lire le fichier contenant la liste des courses. Il l’envoie donc à Arnaud, qui une nouvelle fois doit écrire son propre fichier de compilation.

Le « projet » étant trivial, la traduction du build.bat en build.sh est rapide. Voici pour comparaison les deux fichiers utilisés respectivement par Nicolas et Arnaud. Les différences sont minimes , mais nécessitent une reprise manuelle à chaque modification, pouvant introduire des disparités, voire des incompatibilités entre les environnements de nos deux compères, qui peuvent leur faire perdre un temps précieux.

Listing 1.1 : Les fichiers de compilation utilisés respectivement par Nicolas et par Arnaud

|

|

build.bat

@echo off set JAVA_HOME=C:\jdk1.3 set PATH=%JAVA_HOME%\bin set CLASSPATH=lib\mail.jar;lib\activation.jar mkdir build javac -d build src\*.java jar cf noubliepaslalistedescourses.jar build\*.class |

build.sh

#!/bin/bash export JAVA_HOME=/opt/jdk1.3 export PATH=$JAVA_HOME/bin export CLASSPATH=lib/mail.jar:lib/activation.jar mkdir build javac -d build src/*.java jar cf noubliepaslalistedescourses.jar build/*.class |

De nombreux projets industriels ou communautaires sont confrontés à ce même problème et sont obligés de maintenir deux versions (ou plus) du script de construction du logiciel, soit parce que l’équipe n’est pas homogène, soit parce que l’environnement de test ou de production n’est pas équivalent à celui de développement. Même sur des systèmes d’exploitation identiques, les outils peuvent être installés à des emplacements différents, ce qui oblige à prévoir dans le script un ensemble de propriétés que chacun devra renseigner en fonction de sa configuration.

Sur Unix, ce problème a été traité depuis longtemps par l’outil make. Cependant, celui-ci n’est pas facilement exploitable sur les machines Windows, omniprésentes comme postes de développement.

Arnaud raconte ses déboires à son collègue Olivier. Ce dernier, utilisateur du système Solaris, s’est souvent trouvé face à ce problème ; il lui propose d’utiliser un fichier de commande universel, basé sur l’outil Apache Ant.

Les fourmis à la rescousse

Qu’est-ce que c’est que ce « Ant » ? Faisons un détour par Wikipédia pour nous en faire une idée :

|

Ant [5] est un projet Open Source de la fondation Apache, écrit en Java, qui vise le développement d’un logiciel d’automatisation des opérations répétitives tout au long du cycle de développement logiciel, à l’instar des logiciels Make. Le nom est un acronyme pour Another Neat Tool (un autre chouette outil). |

Ant est principalement utilisé pour automatiser la construction de projets en langage Java, mais il peut l’être pour tout autre type d’automatisation dans n’importe quel langage.

Parmi les tâches les plus courantes, citons la compilation, la génération de pages HTML de document (Javadoc), la génération de rapports, l’exécution d’outils annexes (checkstyle, findbugs, etc.), l’archivage sous forme distribuable (JAR, etc.).

Ant a connu un succès exceptionnel et occupe une place de choix dans la panoplie de tout développeur. Aucun logiciel dédié à Java ne peut aujourd’hui se permettre de ne pas fournir des tâches Ant. Le choix de cette solution semble donc la meilleure marche à suivre !

Pour lui faciliter la tâche, Olivier envoie à Arnaud un script Ant, appelé avec beaucoup d’originalité build.xml, qu’il utilise lui-même sur la plupart de ses projets, et qui est donc rodé et bourré d’options et de paramètres indispensables permettant de le plier à tous les besoins courants.

Aurait-on trouvé avec Ant la solution miracle, rassemblant tous les suffrages ?

Pas si simple : Nicolas, de son côté, désolé d’avoir causé tant de soucis à Arnaud, a reçu le même conseil de Fabrice, qui lui aussi a proposé un script de commandes Ant à tout faire, éprouvé par de nombreuses années d’utilisation. Le fichier d’Olivier suppose que les fichiers sources java sont stockés dans un répertoire sources et que les bibliothèques java sont placées sous libraries. Celui de Fabrice fait des choix différents, respectivement java et libs. De plus, la commande de compilation pour le fichier d’Olivier est ant package alors que celle de Fabrice est ant jar. La fusion de ces deux fichiers, chacun apportant des options intéressantes, est un véritable casse-tête. Rapidement, les quatre compères, qui commencent à se prendre au sérieux avec leur liste de courses, font appel à des connaissances spécialistes d’Ant pour les assister dans cette lourde tâche.

Ant a donc créé un nouveau métier dans le microcosme informatique : expert en script Ant ! Certains projets semblent jouer pour le concours du script le plus inutilement tordu, mixant des paramètres à n’en plus finir (que personne n’a d’ailleurs jamais eu besoin de modifier) et prenant en charge des cas de figure qui tiennent de l’expression artistique, le tout en important d’autres fichiers de script pour éviter l’ignoble copier-coller. S’ils sont fonctionnels, de tels scripts sont un enfer à maintenir et traduisent une organisation suspecte du projet, qui pourrait bien avoir laissé passer un élément de complexité inutile.

Pris au jeu, nos quatre amis – qui ont trouvé un boulot en or pour avoir autant de temps libre – ne s’avouent pas vaincus et veulent poursuivre ensemble le développement de ce projet. Des complications commencent à émerger. Notre petite équipe provenant d’horizons différents, chacun a ses habitudes « maison » et ses bonnes pratiques et voudrait les voir appliquées.

Et Maven dans tout ça ?

Au hasard d’un de ces appels au secours, Jason les prend à contre-pied et leur répond : « Et pourquoi ne pas utiliser plutôt Apache Maven ? » Surpris, et quelque peu incrédules devant cette proposition, ils mettent Jason au défi de compiler ce fameux logiciel avec son outil miracle, là où nos deux scripts Ant, pourtant irréprochables, pris séparément refusent obstinément la fusion. Et dix minutes plus tard, Jason envoie un fichier de quelques lignes, d’une simplicité surprenante, et les instructions de base pour installer Maven. À leur grande surprise, chacun arrive à compiler le projet sur son environnement, quelle que soit sa singularité.

Voici le fichier envoyé par Jason :

<project>

<modelVersion>4.0.0</modelVersion>

<groupId>fr.noubliepaslalistedescourses</groupId>

<artifactId>noubliepaslalistedescourses</artifactId>

<version>0.0.1-SNAPSHOT</version>

<build>

<sourceDirectory>src</sourceDirectory>

</build>

<dependencies>

<dependency>

<groupId>javax.mail</groupId>

<artifactId>mail</artifactId>

<version>1.4</version>

</dependency>

<dependency>

<groupId>commons-io</groupId>

<artifactId>commons-io</artifactId>

<version>1.4</version>

</dependency>

</dependencies>

</project>Comparé aux fichiers Ant testés jusqu’ici, ce fichier « pom.xml » – quel drôle de nom – ne ressemble à rien de connu. Pas de directive de compilation, pas d’indication d’ordre dans les tâches, pas de commande d’assemblage du JAR. Où est le secret ?

Que fait Maven ?

Épluchons point par point les consignes de Jason et voyons.

L’installation de Maven à proprement parler se résume à désarchiver un

fichier ZIP et à définir la variable PATH pour y ajouter le chemin vers

le répertoire apache-maven/bin. Il faut aussi s’assurer d’avoir la

variable d’environnement JAVA_HOME qui indique l’emplacement du JDK

(Java Development Kit), ce qui est généralement le cas sur le poste de

travail des bons développeurs. La construction du projet s’effectue

ensuite via la commande mvn package depuis la ligne de commande. Rien

de bien révolutionnaire donc par rapport au script Ant que nous avions

envisagé.

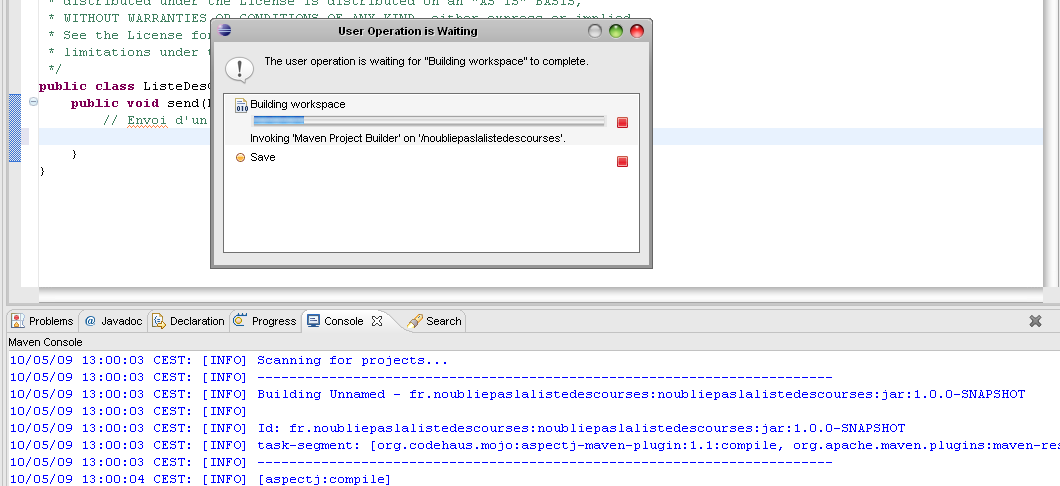

Jason nous a indiqué que Maven nécessitait une connexion à Internet. L’installation n’est donc pas complète, et Maven va rechercher sur le réseau les éléments manquants. Effectivement, la première exécution de Maven se traduit dans la console par une série de messages de téléchargements divers :

D:\noubliepaslalistedescourses>mvn package [INFO] Scanning for projects... [INFO] ------------------------------------------------------------------------ [INFO] Building Unnamed - fr.noubliepaslalistedescourses:noubliepaslalistedescourses:jar:0.0.1-SNAPSHOT [INFO] task-segment: [package] [INFO] ------------------------------------------------------------------------ Downloading: http://repo1.maven.org/maven2/org/apache/maven/plugins/maven-resources-plugin/2.2/maven-resources-plugin-2.2.pom 1K downloaded Downloading: http://repo1.maven.org/maven2/org/apache/maven/plugins/maven-plugins/1/maven-plugins-1.pom 3K downloaded Downloading: http://repo1.maven.org/maven2/org/apache/maven/maven-parent/1/maven-parent-1.pom 6K downloaded Downloading: http://repo1.maven.org/maven2/org/apache/apache/1/apache-1.pom 3K downloaded ...

Cette liste de messages semble même interminable et avoir été conçue pour favoriser le développement d’Internet à haut débit. Tout ça pour notre projet composé de trois classes ? Jason nous a prévenus qu’à la première utilisation, Maven semble télécharger tout Internet, mais il nous a promis des explications ! Mise en garde quelque peu surprenante, mais laissons-lui le bénéfice du doute.

|

La mise en garde de Jason est judicieuse, car de nombreux utilisateurs sont surpris par ce comportement de Maven et sa dépendance à une connexion Internet. Nous verrons par la suite ce qui impose ce mode de fonctionnement et en quoi cela sert les utilisateurs plutôt que de les contraindre. |

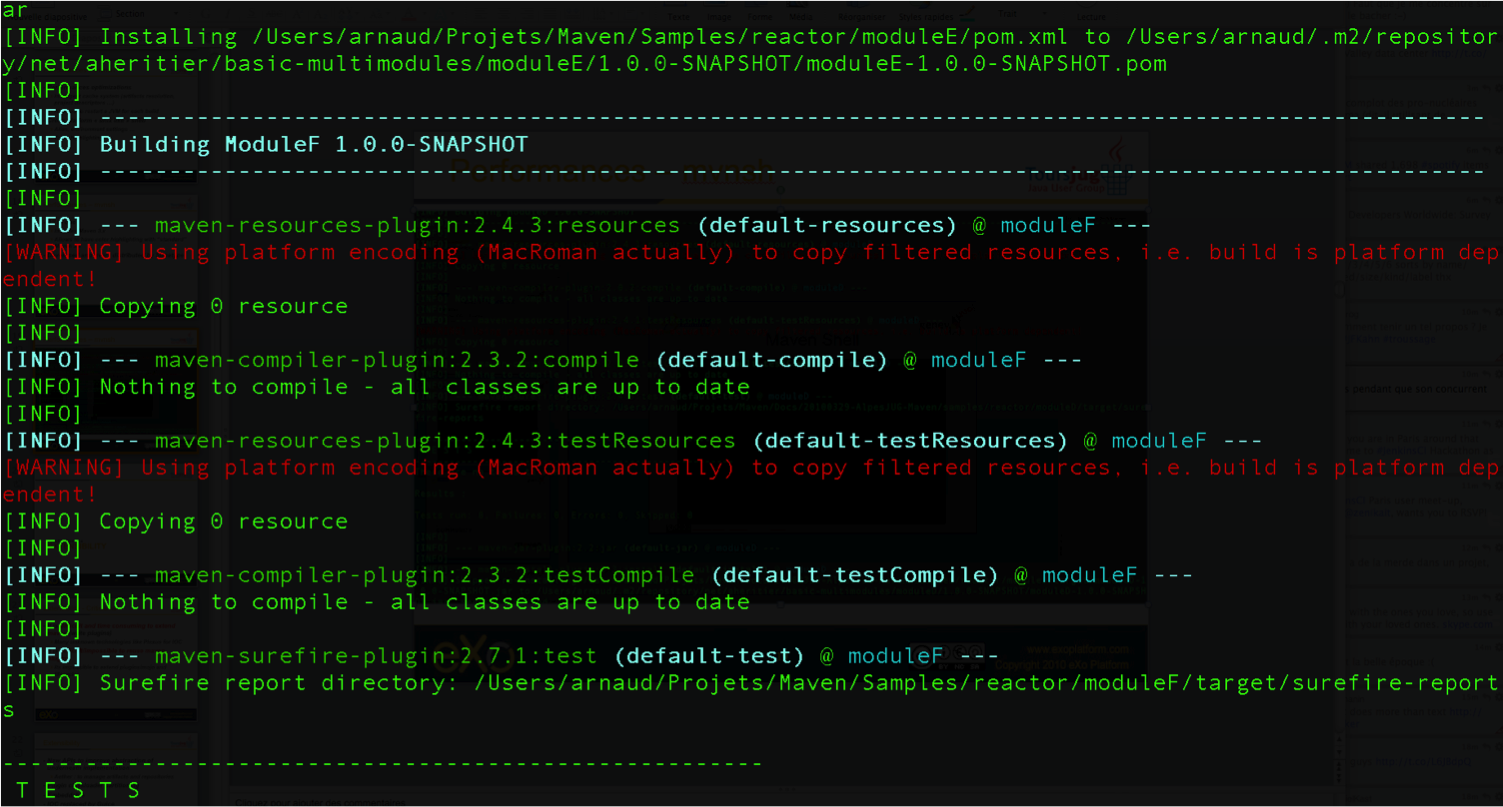

Poursuivons l’analyse des messages que Maven trace dans la console, en ignorant les lignes liées à ces téléchargements étranges mais apparemment nécessaires :

D:\noubliepaslalistedescourses>mvn package [INFO] Scanning for projects... [INFO] ------------------------------------------------------------------------ [INFO] Building Unnamed - fr.maven:noubliepaslalistedescourses:jar:0.0.1-SNAPSHOT [INFO] task-segment: [package] [INFO] ------------------------------------------------------------------------ [INFO] [resources:resources] [INFO] Using default encoding to copy filtered resources. [INFO] [compiler:compile] [INFO] Compiling 3 source files to D:\java\workspace\malistedecourses\target\classes [INFO] [resources:testResources] [INFO] Using default encoding to copy filtered resources. [INFO] [compiler:testCompile] [INFO] Nothing to compile - all classes are up to date [INFO] [surefire:test] [INFO] Surefire report directory: D:\java\workspace\malistedecourses\target\surefire-reports ------------------------------------------------------- T E S T S ------------------------------------------------------- There are no tests to run. Results : Tests run: 0, Failures: 0, Errors: 0, Skipped: 0 [INFO] [jar:jar] [INFO] Building jar: D:\java\workspace\malistedecourses\target\malistedecourses-0.0.1-SNAPSHOT.jar [INFO] ------------------------------------------------------------------------ [INFO] BUILD SUCCESSFUL [INFO] ------------------------------------------------------------------------ [INFO] Total time: 15 seconds [INFO] Finished at: Fri Jan 02 17:02:09 CET 2009 [INFO] Final Memory: 6M/13M [INFO] ------------------------------------------------------------------------

Nous constatons que Maven a compilé nos trois fichiers sources et construit un fichier JAR, ce qu’on attendait de lui, mais il a également tenté de copier des « ressources » et d’exécuter des tests, ensemble de traitements que nous n’avons spécifiés nulle part !

La clé du mystère

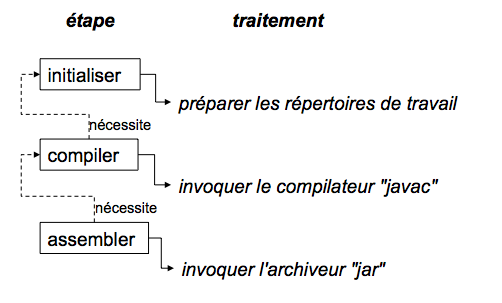

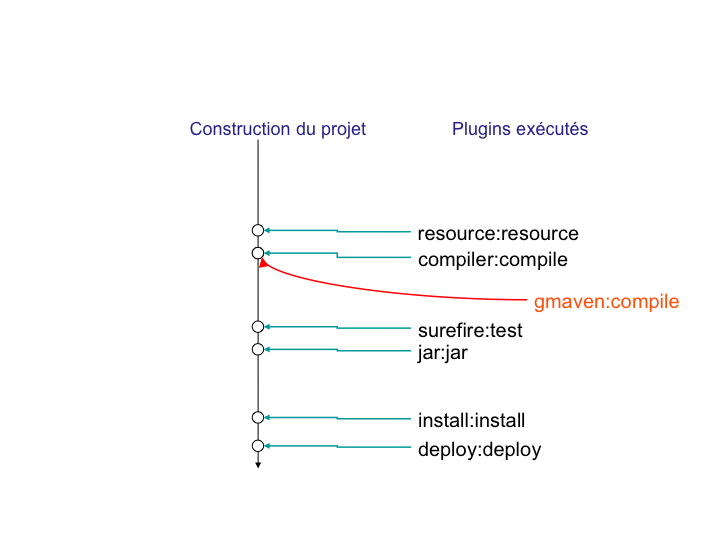

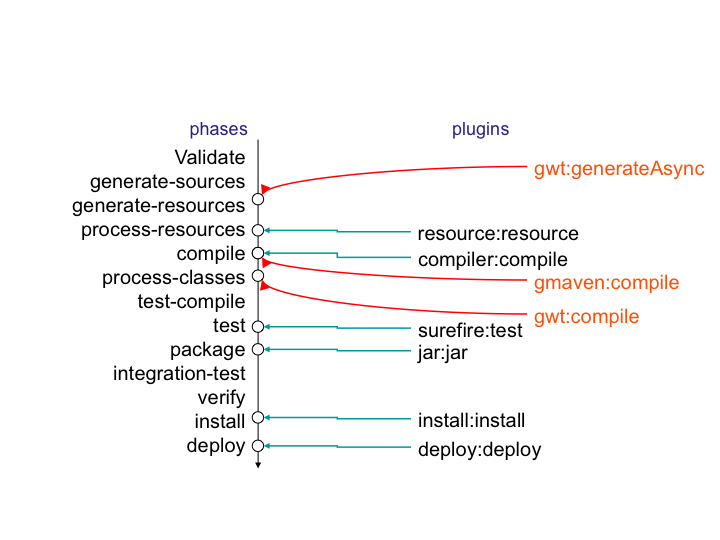

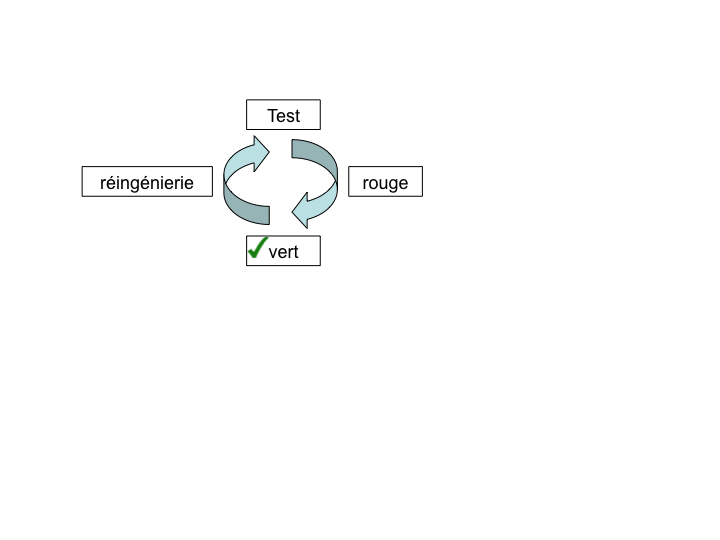

Interrogé sur le sujet, Jason nous livre la clé du mystère : Ant, make et bon nombre d’outils similaires s’appuient sur une approche procédurale, pour laquelle on décrit les opérations à accomplir pour construire le logiciel ou exécuter des tâches annexes. Cela se traduit donc par une suite de commandes, qui prendra d’une façon ou d’une autre la forme décrite à la Figure 01-02.

Les étapes élémentaires de construction d’un projet.

Cette approche fonctionne très bien et permet de faire à peu près tout ce qu’on veut, mais elle nécessite :

-

de répéter pour chaque nouveau projet une liste de tâches très similaires*, ce qui se traduit souvent par la copie d’un fichier de configuration considéré comme « faisant référence » ;

-

de gérer une liste de dépendances entre les étapes clés*, comme, dans notre exemple, « compiler » lorsqu’on désire assembler le JAR.

Maven choisit une approche différente, fondée sur le constat suivant : tous les projets Java vont suivre peu ou prou le même schéma. Les développeurs de Maven considèrent alors qu’il est plus simple de décrire en quoi un projet est différent de ce « scénario type » que de répéter invariablement des commandes très comparables d’un projet à l’autre. Maven exploite donc le concept très structurant de conventions.

Convention plutôt que configuration

Notre pseudoexemple réunissant les étapes « initialiser », « compiler », « assembler » semble s’appliquer à n’importe quel projet informatique, alors pourquoi devons-nous répéter cette déclaration pour chaque projet ? C’est exactement la question que soulève Maven et à laquelle il répond simplement : tout projet Java passe par une phase de préparation, de compilation puis d’assemblage. Ces trois phases ne sont pas propres à un projet, mais liées au développement informatique et s’appliquent à tous.

Maven définit donc un scénario type de construction d’un projet Java, avec des étapes clés prédéfinies et dont l’ordre est immuable. Ce « cycle de vie » est suffisamment large et consensuel pour être applicable à quasiment tous les projets. En admettant que le nôtre n’ait rien de particulier comparé à tous ceux que pilote Maven, nous comprenons mieux comment celui-ci a « deviné » les opérations nécessaires à sa construction.

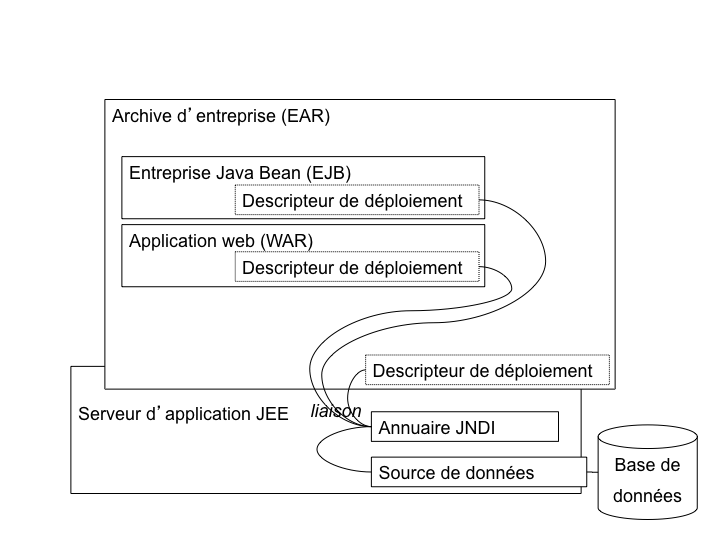

Java Entreprise Edition suit également cette piste en proposant un environnement standardisé et un format de livraison commun pour les applications, même s’il existe de nombreux serveurs d’applications ayant des caractéristiques très variées. Construire une application web Java consiste à assembler une archive WAR (Web Application Archive), que l’on ait choisi JBoss, Webpshere, Tomcat ou Jetty pour l’exécuter. Le comportement par « convention » d’une application web est défini par une norme, chaque serveur proposant des options de configuration pour bénéficier d’un comportement personnalisé lorsque c’est nécessaire. Une convention a, bien sûr, un statut inférieur à une norme comme JavaEE, mais elle apporte la même simplification.

La force des conventions est d’offrir à ceux qui les suivent un outil directement exploitable, sans configuration complémentaire. Une convention de Maven concerne par exemple l’emplacement des fichiers sources Java à compiler. Notre fichier pom.xml contient effectivement une indication sourceDirectory que nous faisons pointer sur le répertoire src. Cette indication n’aurait pas été nécessaire si nous avions suivi la convention. Il nous suffit de l’adopter pour alléger d’autant notre configuration Maven.

Nous verrons en détail plus loin les diverses conventions préconisées par Maven. Certains trouveront cette structure inutilement complexe, peu pratique, ou au contraire parfaitement adaptée à leurs habitudes. L’essentiel n’est pas là, mais dans le fait que Maven propose une organisation par défaut, qui peut fonctionner sans plus d’indications pour tout projet qui la respecte. La force de Maven est de présenter une structure conventionnelle, qui évite à chacun un travail rébarbatif de configuration.

Maven reposant sur un scénario type de construction de projet Java, nous n’avons plus besoin d’indiquer la moindre commande. Il nous suffit de décrire en quoi notre projet est différent de ce cas stéréotypé. Nous passons d’une approche programmatique à une solution déclarative.

Décrire plutôt que programmer

Notre fichier pom.xml de Maven ne compte aucune commande de compilation et, pourtant, il se traduit finalement par l’exécution des outils de compilation et d’assemblage du JDK. Maven fait le choix d’une approche déclarative, dans laquelle on indique les particularités du projet et non la manière de le construire. On précise l’emplacement des fichiers sources, les bibliothèques qui sont nécessaires, plutôt que la ligne de commande du compilateur.

La différence est très significative, car il ne s’agit plus de définir les options de javac, mais de décrire une structure plus générale du projet, qui pourra être exploitée dans un autre contexte. Elle sera, par exemple, utilisée pour s’intégrer dans un IDE (Integrated Development Environment) comme Eclipse ou par les outils d’analyse de code.

POM

Avec ces explications, revenons à présent sur le fichier pom.xml que Jason nous a écrit.

Tout d’abord, pourquoi ce nom ? Nous avons vu que ce fichier ne décrit pas la procédure de construction du projet mais qu’il rassemble des éléments descriptifs. Il est donc logique qu’il ne s’appelle pas build.xml (en dehors du conflit que cela introduirait avec les utilisateurs d’Ant).

Les trois lettres POM sont en fait l’acronyme de Project Object Model. Sa représentation XML est traduite par Maven en une structure de données riche qui représente le modèle du projet. Ces déclarations sont complétées avec l’ensemble des conventions qui viennent ainsi former un modèle complet du projet utilisé par Maven pour exécuter des traitements.

La première partie du POM permet d’identifier le projet lui-même.

<modelVersion>4.0.0</modelVersion>

<groupId>fr.noubliepaslalistedescourses</groupId>

<artifactId>noubliepaslalistedescourses</artifactId>

<version>0.0.1-SNAPSHOT</version>L’élément modelVersion permet de savoir quelle version de la structure de données « modèle de projet » est représentée dans le fichier XML. « 4.0.0 » correspond à la version utilisée par Maven 2.x dans toutes ses variantes.

Les futures versions de Maven 3 pourront exploiter des versions différentes de modèles et introduire des évolutions dans le format de ce fichier. Entre autres, sont envisagés :

-

l’import partiel d’autres fichiers POM (« mixins ») permettant de construire un projet par agrégation de bonnes pratiques,

-

des mécanismes avancés de gestion de dépendance,

-

et tout ce qui pourra s’avérer utile pour rendre Maven 3.x plus puissant et encore plus universel !

L’identifiant de groupe (groupId) permet de connaître l’organisation, l’entreprise, l’entité ou la communauté qui gère le projet. Par convention, on utilise le nom de domaine Internet inversé, selon la même logique que celle généralement recommandée pour les noms de package Java.

L’identifiant de composant (artifactId) est le nom unique du projet au sein du groupe qui le développe. En pratique et pour éviter des confusions, il est bon d’avoir un artifactId unique indépendamment de son groupId.

Enfin, on précise quelle version du projet est considérée. La plupart des projets utilisent la formule <Version Majeure>.<Version Mineure>.<Correctif>, même s’il est difficile d’obtenir un consensus sur la signification exacte de ces numéros et sur leur emploi. Vous pouvez utiliser une chaîne arbitraire, mais la syntaxe numérique permet de faire des comparaisons de versions et de trier celles-ci pour identifier automatiquement la plus récente. SNAPSHOT est un mot clé réservé de Maven, dont nous décrirons la fonction par la suite.

|

Le numéro de version est un concept délicat et changeant selon les organisations et la sensibilité de chacun. Nous vous recommandons une notation purement numérique qui facilite les comparaisons, selon la logique Majeur.Mineur.Correctif. Seules deux versions majeures peuvent ne pas assurer de compatibilité, une nouvelle version mineure peut apporter des fonctionnalités inédites, mais s’interdit de ne pas respecter le mode de fonctionnement existant ; enfin, une version corrective n’apporte aucune fonctionnalité nouvelle mais élimine certains problèmes. Certains enrichissent cette numérotation d’un dernier élément qui indique le degré de confiance dans une version donnée : « RC » pour une Release Candidate (version quasi finale), « GA » pour General Availability pour une version diffusée au public. Cet usage peut porter préjudice au projet car dans la comparaison purement alphabétique, « GA » est inférieur à « RC » ! |

La deuxième partie du POM concerne la construction du projet :

<build>

<sourceDirectory>src</sourceDirectory>

</build>L’approche déclarative utilisée par Maven permet de définir l’emplacement de nos fichiers sources. Le projet étant à la fois très simple et très banal, aucune autre déclaration n’est nécessaire. Si nous avions utilisé le répertoire conventionnel de Maven pour les fichiers sources Java, nous n’aurions même pas eu besoin de ce bloc <build> !

La troisième partie de POM concerne les bibliothèques dont dépend le projet :

<dependencies>

<dependency>

<groupId>javax.mail</groupId>

<artifactId>mail</artifactId>

<version>1.4</version>

</dependency>

<dependency>

<groupId>commons-io</groupId>

<artifactId>commons-io</artifactId>

<version>1.4</version>

</dependency>

<dependencies>Une nouvelle fois, l’approche déclarative prend le dessus : nous

n’indiquons pas l’emplacement physique de ces bibliothèques, à savoir

/lib pour notre projet, mais des identifiants groupId + artifactId

version. Il s’agit des mêmes identifiants de groupe, de composant et de

version, que nous venons de rencontrer, appliqués à une bibliothèque.

Nous indiquons, par exemple, que nous utilisons l’API standard JavaMail

en version 1.4.

Nous avons ici une réponse partielle à notre question sur la nécessité d’un accès Internet : Maven va télécharger les bibliothèques indiquées, à partir d’une source fiable, plutôt que de se contenter des fichiers JAR présents dans le répertoire /lib et dont la version et l’origine sont incertaines. L’espace contenant l’ensemble des bibliothèques téléchargées est un dépôt d’archives local (local repository) et respecte une convention. Nous verrons en détail au Chapitre 2 les raisons de cette approche et ses avantages.

Pourquoi adopter ces conventions ?

Nous venons de le voir, Maven propose un ensemble de conventions qui permettent d’outiller le projet avec peu de configuration. Il ne nous interdit cependant pas de choisir nos propres conventions, comme le répertoire src pour les sources du logiciel.

Dans ce cas, pourquoi adopter les conventions de Maven, alors qu’il suffit de quelques lignes de déclaration supplémentaires pour « plier » Maven à nos habitudes ? Hostiles au changement, comme une grande majorité des êtres humains, nous préférons cette option.

C’est à ce moment qu’Emmanuel se propose de nous rejoindre, lui aussi à temps perdu grâce à son boulot en or, pour enrichir notre projet d’un grand nombre de nouvelles fonctionnalités. Emmanuel est déjà habitué à Maven et peut donc être rapidement productif et nous aider à le configurer correctement. Seulement, les choses ne se passent pas aussi simplement que prévu, car malgré son expérience de l’outil, Emmanuel ne retrouve pas ses petits : pour ajouter des tests à notre architecture, il doit créer un nouveau répertoire de sources, indépendant de celles du projet. Or notre répertoire src n’a qu’un seul niveau et ne permet pas de différencier le livrable des tests. Il est donc obligé de déclarer une nouvelle dérogation aux conventions de Maven.

Par ailleurs, même si les différences sont minimes, il est contraint d’adapter toutes ses petites habitudes à notre structure de répertoire, qui n’est pas « strictement conforme Maven ».

Les conventions de Maven ne sont pas obligatoires, cependant réfléchissez à deux fois avant de vouloir en imposer d’autres pour votre projet. D’une part, vous allez vous compliquer inutilement la tâche en ne profitant pas du comportement par défaut que propose Maven, et chaque nouvelle option activée pourra se traduire par une nouvelle phase de configuration. À moins d’être passionnés par l’éditeur XML, peu de développeurs prennent du plaisir à perdre un temps précieux dans des fichiers de configuration, Maven ou autres.

Ensuite, pensez à la gestion de vos équipes et à l’intégration de nouveaux développeurs. Maven offre l’occasion de définir une fois pour toutes la structure de tous vos projets Java, de manière homogène. Un développeur pourra passer d’un projet à un autre sans perdre son temps à apprendre les petites habitudes locales : où sont les fichiers de configuration ? Dans quel répertoire place-t-on les données de test ? Tous les projets qui se conforment aux conventions Maven seront identiques de ce point de vue, et le développeur sera plus rapidement productif.

Enfin, contrairement à une politique « maison » qui aurait pu établir ce type de conventions, celles de Maven sont partagées par la majorité des développeurs qui ont adopté ce logiciel. Tout nouveau membre de votre équipe qui a déjà travaillé sur un projet Maven trouvera rapidement ses repères. Maven et ses conventions deviennent au fil des années le standard de facto dans le monde professionnel Java, car un développeur trouve immédiatement ses marques lorsqu’il aborde un nouveau projet.

La force des conventions de Maven n’est pas dans le nom des répertoires qui ont été choisis, mais dans le fait qu’il offre à la communauté des développeurs Java tout entière une base commune.

La force de Maven

Revenons un peu en arrière : le projet initial, que nous pouvons considérer comme un prototype, était difficilement exportable en dehors de l’environnement de son créateur. Il nécessitait un script de compilation à la fois indispensable et sans grande valeur ajoutée, étant d’une grande banalité.

L’adoption d’Ant aurait pu partiellement résoudre le problème, mais pour tirer parti de la richesse des outils qui peuvent lui être greffés, il aurait fallu que tous les scripts Ant adoptent une structure de base commune. En l’absence d’une convention dans la communauté Ant pour les éléments principaux qui gouvernent un projet Java, il peut être extrêmement délicat de réutiliser et de fusionner des éléments provenant de sources indépendantes. Enfin, tout ce travail aurait été réalisé par des copier-coller qu’il aurait fallu répéter pour notre prochain projet.

Maven propose de passer à une approche déclarative, dans laquelle nous considérerons notre projet comme une variation sur un thème commun. Nous ne nous soucions plus de savoir quelle opération doit suivre quelle autre lors de la construction du logiciel. Nous déclarons juste les quelques éléments spécifiques qui font de notre projet quelque chose d’unique.

En adoptant des conventions, nous réduisons à quelques lignes les informations que nous devons déclarer pour que le projet soit pris en charge par Maven. La maintenance et l’ajout de nouvelles tâches au cours de la construction du projet s’en trouvent simplifiés. Un développeur, issu d’un contexte très différent mais déjà utilisateur de l’outil, peut prendre le projet en main sans difficulté particulière.

La combinaison de conventions et d’une approche innovante fondée sur la description du projet fait de Maven un outil à part, très différent d’Ant ou de ses équivalents. Au cours des chapitres qui suivent, nous allons voir en quoi cette approche se généralise à toutes les tâches qui accompagnent la vie d’un projet.

Chapitre 2 : Au-delà de java.lang

Des JAR sous CVS

Avec une équipe qui se compose désormais de cinq développeurs motivés, il n’est plus question de s’envoyer par e-mail des archives du projet pour transmettre aux autres les nouvelles fonctions que l’on vient de développer. Un projet en mode collaboratif utilise un outil de gestion de sources pour partager le code, synchroniser les développements et gérer les conflits lorsque deux personnes travaillent sur le même fichier. Ce gestionnaire de sources (SCM – Source Control Management) est typiquement CVS (Concurrent Version System), Subversion ou, plus récemment, Git.

Comme son nom l’indique, cet outil est prévu pour contenir des fichiers sources et non des binaires issus d’une compilation. Pourtant, de nombreux projets placent les bibliothèques et les outils nécessaires au projet dans leur gestionnaire de sources. L’idée peut sembler bonne a priori, car elle vise à gérer avec un unique outil et, de manière homogène, tous les éléments nécessaires au développement du projet. Sauvegarder les bibliothèques Java dans le SCM est donc une garantie de retrouver à tout moment la version exacte qui est utilisée par le projet.

Notre prototype ne déroge pas à cette « bonne idée » et possède comme tant d’autres un répertoire lib avec l’ensemble des bibliothèques utilisées.

Quand le répertoire lib explose

La croissance de l’équipe nous permet de rapidement améliorer notre prototype. Le nombre de bibliothèques nécessaires au projet augmente. Nous commençons par introduire Spring pour rendre le code plus évolutif avec l’utilisation des concepts de l’injection de dépendances. Ensuite, nous remplaçons tout le code écrit en JDBC par Hibernate et Java Persistence API. Nous développons une interface web sympathique basée sur Wicket et, enfin, nous faisons appel à Apache CXF pour exposer nos services à d’autres applications sous forme de services web.

Le nombre de bibliothèques croît exponentiellement car, au-delà de la gestion de celles que nous utilisons explicitement au sein du projet, il faut gérer toutes les bibliothèques qui leur sont nécessaires. Rapidement, le répertoire lib se retrouve chargé de dizaines de fichiers JAR avec des noms plus ou moins hétéroclites.

Les choses se compliquent alors significativement et la moindre mise à jour d’une bibliothèque relève d’un casse-tête chinois.

D’une part, cette pratique encourage à utiliser ces bibliothèques telles quelles, sans chercher à s’assurer de leur origine ou de la fiabilité de leur téléchargement. Comme il est délicat de comparer deux versions d’un fichier binaire, il nous est impossible de savoir en quoi notre fichier util.jar diffère de celui utilisé sur un autre projet comparable, dont nous voulons importer des classes intéressantes. Même si ces deux fichiers portent le même nom et ont la même taille, cela ne signifie pas qu’ils soient identiques. Seule une comparaison binaire pourrait nous en assurer.

Autant dire qu’avec les dizaines de bibliothèques embarquées dans notre projet, plus personne ne fait scrupuleusement cette vérification, et nous nous contentons de lire le nom de l’archive mail-1.2.jar pour identifier la bibliothèque JavaMail.

Cela nous amène à un second problème possible. Supposons que cette bibliothèque ait été corrompue lors de son téléchargement depuis le site de SUN qui la diffuse ou de son enregistrement dans notre SCM. Un transfert réseau n’est jamais 100 % garanti, et un seul bit modifié peut rendre la bibliothèque inutilisable, sans parler de ces charmants petits virus qui peuvent traîner un peu partout. L’identification du problème peut être extrêmement complexe, car la remise en cause de la bibliothèque sera probablement la toute dernière hypothèse que nous évoquerons pour justifier un dysfonctionnement.

Un bogue est détecté

Après quelques heures de tests et de recherche d’informations sur Internet, nous devons nous rendre à l’évidence, nous rencontrons un bogue connu de la bibliothèque JavaMail utilisée sur le projet. Seule solution viable : la mise à jour de cette bibliothèque dans une version plus récente.

Le téléchargement de la distribution JavaMail depuis le site de SUN [6] donne un fichier ZIP contenant à la fois les binaires et la documentation de cette API ; les**binaires, car JavaMail regroupe en fait plusieurs archives JAR, à savoir mail.jar, mais aussi mailapi.jar. La première contient l’ensemble du code public JavaMail alors que la seconde ne comprend que les API de programmation, et pas la gestion des protocoles de transfert de messages (pop, smtp, imap…) qui sont optionnels. Lequel utilisons-nous actuellement ? Par quoi le remplacer ?

En supposant que nous sachions répondre sans ambiguïté à cette question, nous devons supprimer le mail-1.2.jar utilisé jusqu’ici et ajouter le nouveau mail-1.4.1.jar. Cela nous impose de modifier tous nos scripts de gestion du projet (scripts de compilation et de lancement, fichiers de configuration Eclipse, NetBeans ou IntelliJ Idea…) pour tenir compte de ce changement, avec le risque d’introduire, par mégarde, des erreurs. Ce simple changement nous oblige donc à la fois à faire preuve de beaucoup de soin et à vérifier le fonctionnement de nos scripts.

Pour éviter ces risques, une seconde option consiste à ne pas indiquer de numéro de version pour les bibliothèques. Nous utilisons le nom de fichier mail.jar et le remplaçons purement et simplement par le nouveau fichier en cas de mise à jour. Ayons alors une pensée compatissante pour les équipes de maintenance qui, dans quelques années, devront deviner la version exacte des bibliothèques utilisées sur notre projet, dont certaines seront devenues plus ou moins obsolètes et connues pour certains bogues graves. Le problème devient encore plus complexe lorsqu’on doit utiliser une version modifiée d’une bibliothèque, par exemple parce qu’on y a intégré un correctif qui n’est pas encore pris en compte dans une version officielle.

|

Le format d’archive JAR prévoit un fichier de métadonnées, META-INF/MANIFEST.MF, décrivant théoriquement la bibliothèque, et en particulier sa version précise. Celle-ci est cependant régulièrement non documentée lorsque ce fichier MANIFEST n’est pas tout simplement absent ou quasiment vide. |

lib/*.jar

Pour ne plus rencontrer ce problème, nous décidons « d’assouplir » nos scripts de compilation en utilisant l’intégralité du répertoire lib comme chemin d’accès aux classes, plutôt qu’une liste explicite de bibliothèques. Placer une nouvelle bibliothèque dans ce répertoire ou en remplacer une par une autre version ne nécessitera alors aucune modification des scripts.

Ce qui pourrait ressembler à la solution miracle n’est pas aussi parfait qu’il y paraît. D’abord, cela ne résout pas la configuration de notre environnement de développement qui continue de réclamer une liste précise de bibliothèques à inclure dans le ClassPath. Ensuite, une manipulation malheureuse de nos fichiers JAR ne se verra pas immédiatement – un glisser-déposer est si vite arrivé ! Il faudra attendre qu’elle ait un impact visible pour devoir ensuite remonter à l’origine du problème.

Enfin, ce n’est pas une solution d’une grande élégance. Pour éviter de devoir traiter le problème, nous avons ouvert les portes en grand à tout ce qui passe. Difficile de parler de « maîtrise » de nos bibliothèques dans de telles conditions.

Identification univoque

Maven propose une approche à l’opposé de ces pratiques hasardeuses. Il se focalise sur l’identification exacte des bibliothèques utilisées. Des référentiels de bibliothèques sur Internet lui sont dédiés et permettent de télécharger les bibliothèques précises, utilisées dans le projet, sans ambiguïté. Les risques d’erreur de transfert sont éliminés par un contrôle automatique basé sur des fonctions de hachage (une sorte d’empreinte digitale du binaire, qui sera invalidée au moindre bit différent).

L’identification d’une bibliothèque utilisée par un projet s’appuie sur un triplet (identifiant de groupe, identifiant d’artefact, version précise), lequel est construit sur le même principe que celui que nous avons déclaré pour notre projet. Dans le fichier POM de Jason, nous référençons l’artefact mail de la bibliothèque standard javaMail dans sa version 1.4.

<dependency>

<groupId>javax.mail</groupId>

<artifactId>mail</artifactId>

<version>1.4</version>

</dependency>Il n’y a ici aucune équivoque possible. Toute autre variante de JavaMail possédera dans le dépôt Maven un numéro de version différent. Si nous devions nous-mêmes appliquer un correctif, nous devrions utiliser un numéro de version adéquat, comme 1.4-patch-1234. Dans ce cas, cette bibliothèque modifiée serait placée dans notre dépôt privé, comme nous le verrons au Chapitre 6.

Notre projet inclut également une mystérieuse bibliothèque util.jar. Nicolas ne se souvient pas du tout de l’origine de ce fichier. Les équipes de maintenance, confrontées à ce cas de figure, auraient du fil à retordre. Comment gérer une mise à niveau ou un bogue rencontré dans la bibliothèque considérée si on est incapable de l’identifier avec précision ?

Dans le contenu de cette archive Java, les packages utilisés, org.apache.commons.io, nous mettent sur la piste, et c’est ce qui a inspiré à Jason la déclaration d’une dépendance vers Apache Commons-io. Cependant, il pourrait s’agir d’une version modifiée, pour une quelconque raison, avec je ne sais quel impact possible sur l’application.

L’identification exacte réclamée par Maven oblige à préciser quelle version est utilisée et à définir des numéros de version pour chaque variante de la bibliothèque ou version modifiée que l’on voudrait utiliser.

Ajouter une bibliothèque à un projet Maven se traduit simplement par l’ajout d’un bloc <dependency> comparable à notre exemple, identifiant sans équivoque notre intention. Pas de script à éditer, pas de fichier JAR à télécharger et donc pas de validation du fichier téléchargé ; pas de répertoire de bibliothèques à modifier, avec les risques d’erreur de synchronisation qui en découleraient. Mettre à jour une bibliothèque consiste tout simplement à modifier l’information de version qui lui est associée.

|

Les bibliothèques standard de Java sont hébergées par SUN et devraient donc être placées sous le groupe com.sun.java. Elles ne peuvent cependant pas être considérées comme des fournitures appartenant à cet éditeur. Aussi, la convention pour ce cas particulier veut qu’on utilise le nom de package javax.* qui caractérise ces API. Par ailleurs, il existe de nombreuses exceptions pour des raisons historiques liées à la première mouture de Maven. |

Dépôt de bibliothèques

La configuration par défaut de Maven utilise le dépôt (ou référentiel) de bibliothèques http://repo1.maven.org/maven2/. Ce site, maintenu par la communauté Maven, compte plusieurs dizaines de gigaoctets de bibliothèques libres de diffusion, et il est mis à jour plusieurs fois par jour. Nous verrons au fil des prochains chapitres comment utiliser d’autres dépôts et en construire un pour nos besoins propres.

À partir de notre déclaration de dépendance, Maven va construire l’URL du sous-répertoire dédié à la bibliothèque indiquée :

<URL du dépôt> / <groupId en tant que chemin> / <artifactId> / <version>

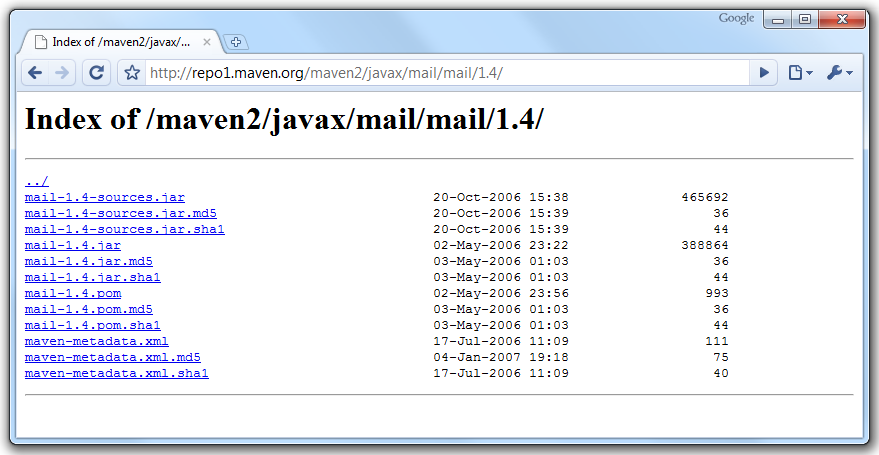

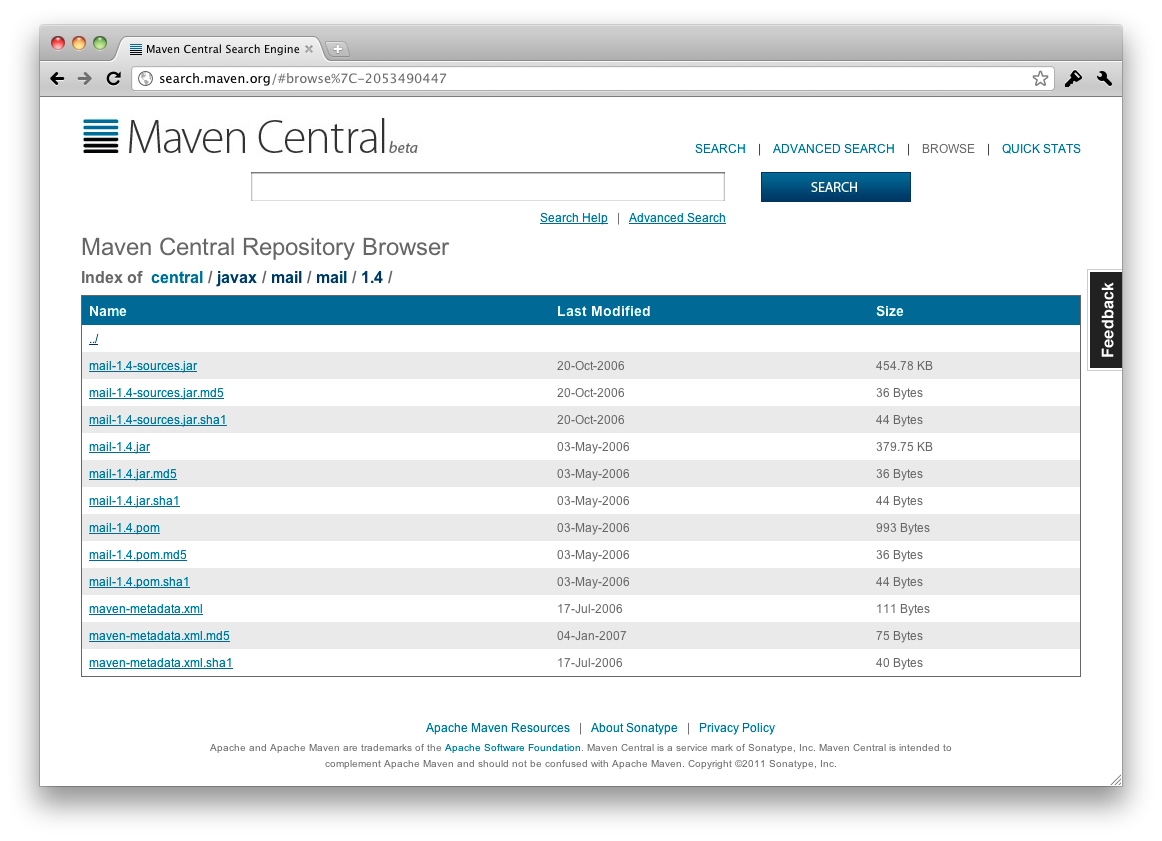

Pour notre dépendance à JavaMail, nous obtenons : http://repo1.maven.org/maven2/javax/mail/mail/1.4/.

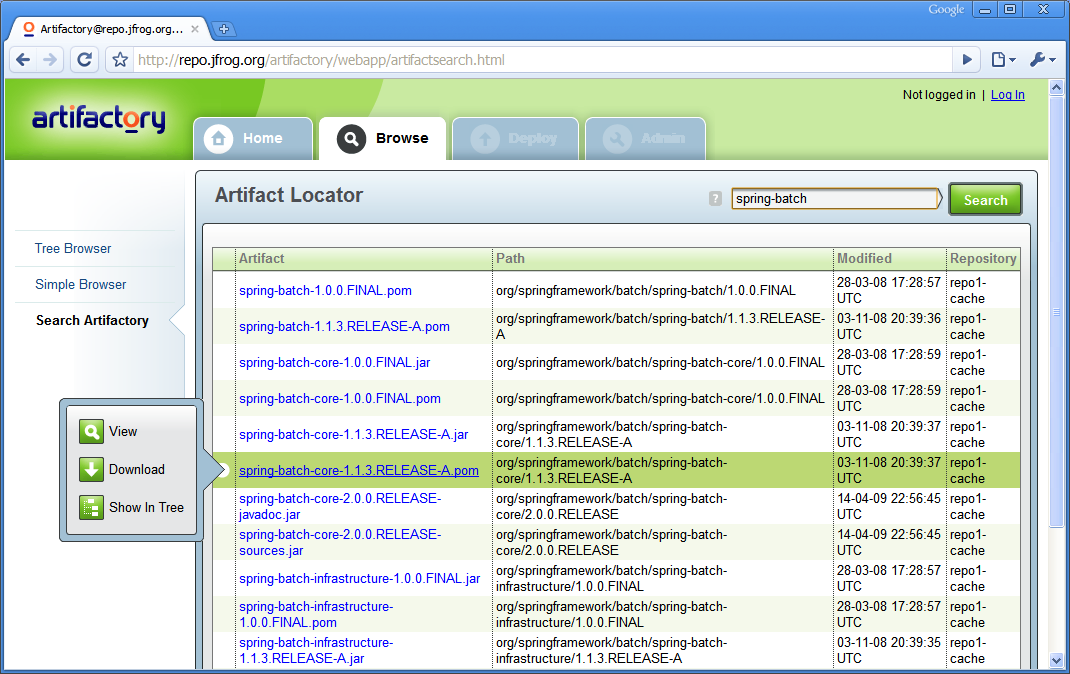

Le sous-répertoire dédié à JavaMail 1.4 sur le dépôt de bibliothèques.

En plus du fichier JAR de la bibliothèque attendue, nous trouvons de nombreux autres fichiers dans ce répertoire :

-

chaque fichier présent est accompagné de deux partenaires, avec respectivement l’extension .md5 et .sha. Il s’agit des empreintes de contrôle associées au fichier, que Maven exploitera pour s’assurer que le fichier n’a subi aucune altération au cours du téléchargement ;

-

un fichier porte le même nom que la bibliothèque avec le suffixe -sources. Il s’agit, comme on pourrait s’en douter, d’une archive des sources Java de la bibliothèque, ce qui pourra se montrer fort utile depuis votre environnement de développement intégré préféré pour utiliser un débogueur et parcourir le code de cette bibliothèque. Il pourrait également y avoir un autre fichier avec le suffixe -javadoc contenant la documentation technique de la bibliothèque ;

-

un autre fichier ayant le même nom que la bibliothèque avec l’extension .pom. Il s’agit bien de l’acronyme du Project Object Model que nous connaissons déjà. Chaque bibliothèque dans le dépôt Maven possède un fichier de ce type. Soit parce que la bibliothèque a été développée en utilisant Maven, soit parce qu’un fichier minimal a été écrit pour fournir une description de la bibliothèque aux utilisateurs de Maven ;

-

un fichier de métadonnées, propre à Maven comme son nom l’indique clairement.

Avis aux amateurs de casse-tête

Notre projet, issu d’un code antédiluvien auquel chacun est venu apporter sa contribution, est constitué de bric et de broc. Le répertoire lib devient un sacré fourre-tout, et c’est réellement compliqué de savoir pour quelle raison nous avons dû introduire commons-net-1.3.jar dans le projet. Aucune de nos classes ne fait référence à ce package !

Lorsqu’on fait appel à une bibliothèque pour prendre en charge certaines fonctions techniques, il est rare qu’elle se suffise à elle-même. Au même titre que notre projet, elle fait appel à d’autres bibliothèques spécialisées pour lui fournir des composants de haut niveau qui lui facilitent la tâche. Sa documentation précise, bien évidemment, les prérequis, ce qui nous a permis lors de son introduction dans le projet de connaître la liste de bibliothèques à ajouter pour avoir un ensemble fonctionnel. Certaines étaient déjà intégrées, et il a fallu nous assurer que la version demandée était compatible avec celle que nous utilisions et, éventuellement, faire la mise à jour qui s’imposait.

Les bibliothèques de haut niveau, telles que le framework Spring, introduisent dans le projet un nombre important de bibliothèques. Les choses se compliquent lorsqu’on désire changer de version pour profiter de nouvelles fonctionnalités ou d’un correctif. Nous devons retracer à la main la chaîne complète des bibliothèques pour identifier ce qui a changé, en nous fondant sur la documentation respective de chaque bibliothèque rencontrée pour connaître ses prérequis et ses éventuelles incompatibilités.

Pour nous épargner une migraine, les développeurs de bibliothèques ont heureusement pris la bonne habitude de ne jamais briser la compatibilité avec les versions précédentes sans un avertissement visible. La pratique la plus courante consiste à utiliser le numéro de version et à passer à une version « majeure » supérieure. Entre la version 1.4 et la version 2.0, il est assez probable que des modifications lourdes ont été apportées, limitant fortement la compatibilité, ce qui justifie le changement de version. Par contre, nous pouvons être plus confiants dans une migration vers une 1.4.2 ou une 1.5, et relâcher (dans la limite du raisonnable) notre surveillance pour passer d’une 1.4.2 à une 1.4.3.

Malgré cette pratique courante, la gestion de la chaîne de dépendances entre bibliothèques peut devenir réellement complexe, si on ne veut oublier personne en route. L’absence d’une bibliothèque peut provoquer des erreurs non évidentes et qui n’apparaîtront pas nécessairement au premier démarrage de l’application. Quant à lire attentivement la documentation de chaque bibliothèque, aucun développeur ne trouve le courage de le faire systématiquement.

La plupart du temps, on se contente donc de prendre la distribution binaire de la bibliothèque et de fusionner son répertoire lib avec celui du projet, en tentant d’identifier les doublons. Même si cela fonctionne relativement bien dans de nombreux cas, il est certain qu’on part au petit bonheur la chance en espérant ne rien laisser traîner en route.

L’ami de mon ami…

Que propose Maven pour cette situation ? Nous avons vu qu’il nous demande de déclarer les dépendances plutôt que de fournir nous-mêmes les binaires ; aussi, notre dernière option – prendre la distribution telle quelle et la fusionner avec notre répertoire lib – n’est pas applicable. Maven va-t-il nous obliger à éplucher la documentation de chaque bibliothèque utilisée ?

Maven est autrement plus subtil : jetez un coup d’œil quelques pages en arrière, sur le contenu du répertoire lib de notre projet initial :

\lib

\mail.jar

\activation.jar

\util.jar

Nous utilisons trois bibliothèques, la première est l’API JavaMail, la deuxième le Bean Activation Framework, nécessaire au bon fonctionnement de JavaMail, et enfin le mystérieux util.jar qui s’est avéré être Apache commons-io. Le fichier POM.xml ne compte que deux entrées <dependency>, là où notre projet nécessite trois bibliothèques. Jason aurait-il été un peu trop vite ?

Si vous jetez à nouveau un œil aux traces de téléchargement dont Maven nous a abreuvé au premier lancement, vous constaterez qu’il télécharge à la fois des fichiers POM et des fichiers JAR – comme s’il ne téléchargeait pas déjà assez de choses !

Ces fichiers POM, au même titre que celui de notre projet, décrivent les bibliothèques auxquelles ils sont associés. Pour JavaMail, l’archive mail-1.4.jar est ainsi accompagnée d’un mail-1.4.pom. Il s’agit bien d’un fichier Project Object Model, au même format XML que pour notre projet et qui comprend des déclarations comparables, en particulier des dépendances. C’est ici qu’est indiqué le lien entre JavaMail et le Bean Activation Framework. Cela permet à Maven de savoir que tout projet qui utilisera l’API JavaMail aura nécessairement besoin du JAR Activation. Si celui-ci a aussi des dépendances, la chaîne se poursuivra, jusqu’à ce qu’un graphe complet de bibliothèques interdépendantes soit construit.

On parle, pour ces données qui décrivent la bibliothèque, de « métadonnées ». Il s’agit d’une version compacte et normalisée au format POM des informations que nous aurions pu obtenir en lisant la documentation de la bibliothèque : sa licence, le site web qui l’héberge, et ses prérequis. L’exploitation automatisée de ces données permet à Maven de construire l’arbre des dépendances du projet, chaque nouvelle feuille pouvant, par ses propres métadonnées, introduire de nouvelles branches.

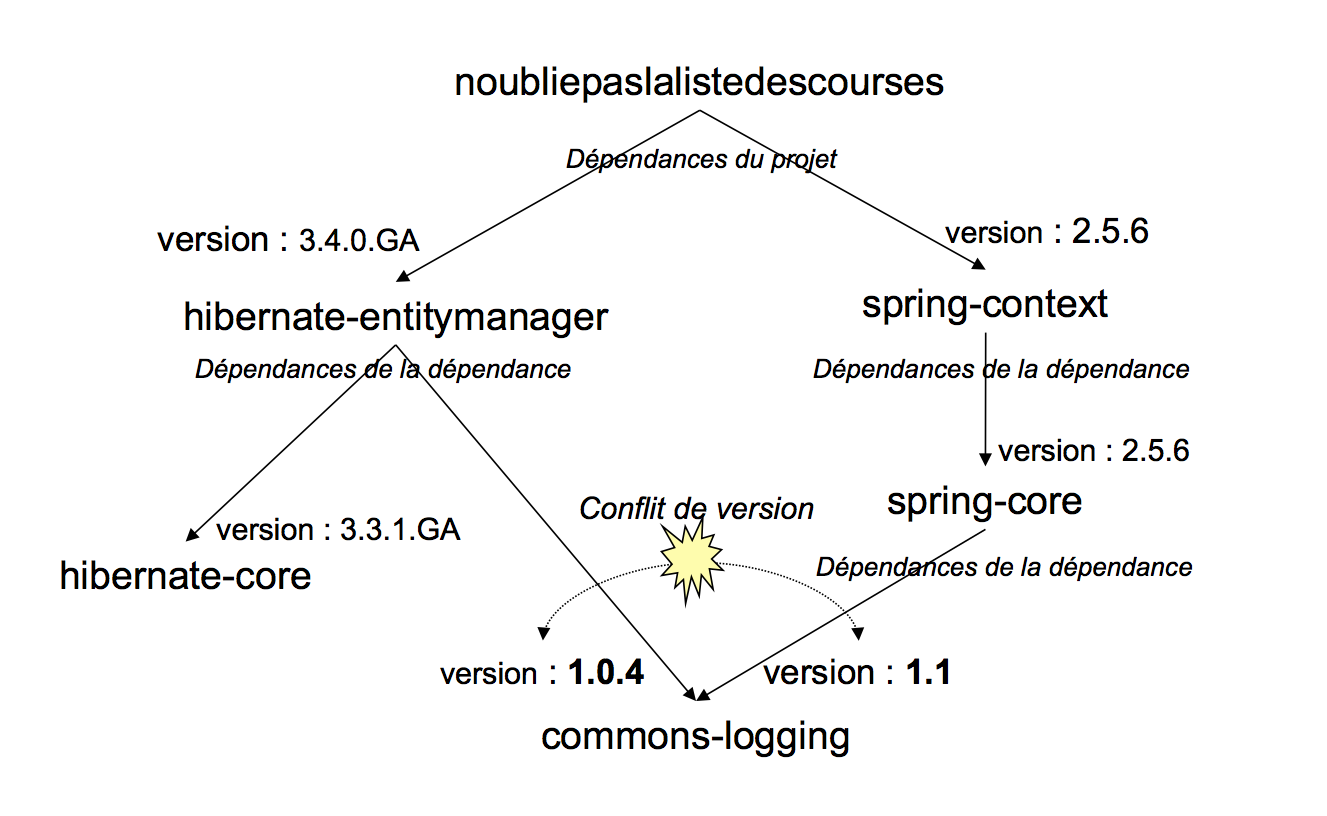

Arbre de dépendances transitives.

Cet arbre, extrêmement difficile à construire à la main et douloureux à maintenir, est analysé automatiquement par Maven à chaque exécution. Il s’assure que l’ensemble des bibliothèques nécessaires est présent et il construit ainsi le chemin de classes utilisé par le compilateur. Maven va également gérer les problèmes de conflit de versions, lorsque l’arbre fait apparaître plusieurs fois la même bibliothèque dans des versions différentes. Le mécanisme utilisé est cependant limité par la liberté laissée aux numéros de versions qui rend délicate une comparaison 100 % déterministe.

|

L’algorithme de résolution des conflits se fonde sur le principe de « proximité » : Maven compte, dans l’arbre des dépendances, combien de branches séparent la bibliothèque du projet ; celle qui est déclarée au plus près gagne. En cas d’égalité, l’ordre de déclaration des dépendances détermine le vainqueur : la première déclaration dans l’ordre du POM gagne. Ce comportement a été figé avec Maven 2.0.9 (les versions précédentes étaient non déterministes sur ce point, si vous les utilisez encore, mettez à jour en urgence votre boite à outils ! |

Cette dernière fonctionnalité finit par nous convaincre définitivement. Aussi, nous abandonnons nos différents scripts et adoptons les conventions de Maven pour la suite du développement de noubliepaslalistedescourses. Les développeurs sont nombreux à choisir Maven pour sa gestion des dépendances. N’oubliez pas, cependant, tous les points que nous avons déjà vus, et en quoi cela différencie Maven d’autres outils de construction de projet. Maven n’est pas juste un outil de gestion des dépendances, pour lequel il existe d’autres très bons outils comme Apache Ivy qui sont utilisables depuis un script Ant.

Ayez bien en tête les points forts et la philosophie de Maven, si vous envisagez de convertir un projet existant, car vous devrez probablement en repenser l’organisation, et pas juste écrire quelques fichiers POM pour déclarer vos dépendances.

Testons un peu

Vincent est un fanatique de la qualité logicielle, aussi a-t-il fait un gros travail d’évangélisation pour nous convaincre d’outiller notre projet de tests automatisés (nous en reparlerons au Chapitre 4). Ceux-ci permettent de contrôler à tout moment que les fonctionnalités de notre projet ne sont pas impactées par une modification, ce qui constitue une sécurité et un gain de temps appréciables.

Nous étions sur le point de décerner à Vincent le prix très convoité de « développeur du mois », quand nous avons rencontré un bogue étrange sur l’application, signalant l’absence de la classe org.junit.Assert dans l’environnement d’exécution. Voilà un problème bien curieux.

Après une rapide recherche, nous constatons qu’une erreur d’import dans une classe a fait utiliser org.junit.Assert#assertNotNull() à la place de la classe similaire de Spring org.springframework.util.Assert#notNull(). La gestion automatique des imports par notre environnement de développement intégré est bien pratique mais elle peut parfois avoir des effets pervers [7]. Comment se fait-il que cette erreur d’étourderie soit passée au travers des mailles de notre (excellent) suivi qualité ? Ou plutôt, comment se fait-il que notre outillage qualité ait pu ajouter des bogues à notre application ?

La réponse tient en un mot : dépendances. Notre gestion des dépendances à la hussarde, avec un répertoire lib dont nous utilisons tous les JAR sans distinction, ne sait pas différencier les bibliothèques nécessaires à la compilation de celles utilisées par les outils de test.

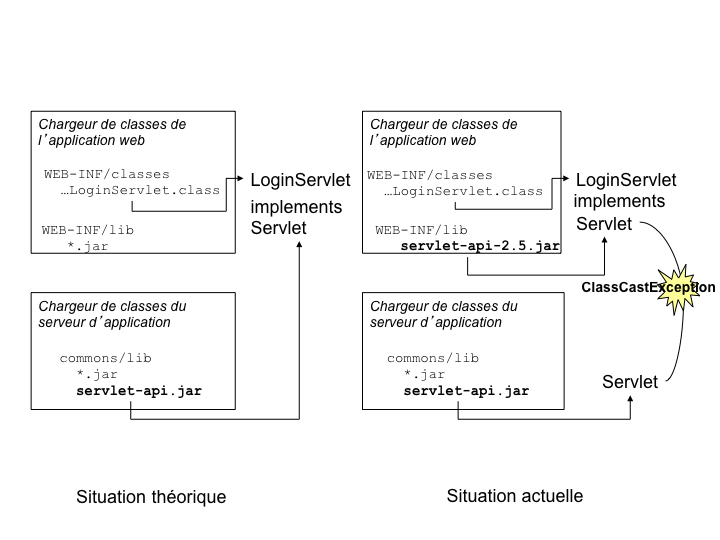

Nous pourrions fiabiliser les choses en séparant nos bibliothèques en /lib/runtime et /lib/test, mais Jason nous arrête net : que penser des API servlet, que nous utilisons pour compiler notre interface de gestion web (l’application a pas mal évolué depuis le prototype en ligne de commande !). Ces bibliothèques sont nécessaires pour compiler, mais elles ne doivent pas être intégrées à l’application pour respecter les règles JavaEE, car elles sont déjà présentes dans notre serveur d’application.

Cela se complique. Peut-être qu’avec un troisième sous-répertoire dans /lib… Stop ! Fini de jouer, interrompt Jason, avant de nous expliquer comment Maven traite de manière globale ce problème.

Les « scopes »

Notre problème vient de la nécessité d’associer à chaque dépendance du projet le contexte dans lequel elle doit intervenir. S’agit-il d’un élément indispensable à l’exécution du logiciel ? Est-il utilisé uniquement à des fins de test ? Doit-il être inclus dans l’application ou est-il intégré dans l’environnement d’exécution ?

La déclaration d’une dépendance Maven permet de définir un élément supplémentaire, le « scope » dans lequel la dépendance devra s’appliquer. Nous pouvons ainsi préciser que la bibliothèque jUnit n’est utilisée que durant la phase de test et que l’API servlet ne doit pas être intégrée dans notre archive web.

<dependency>

<groupId>javax.servlet</groupId>

<artifactId>servlet</artifactId>

<version>2.3</version>

<scope>provided</scope>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.7</version>

<scope>test</scope>

</dependency>Maven exploite ces données supplémentaires lorsqu’il exécute les commandes de construction du projet. Avec cette précision, jUnit ne sera pas inclus sur la liste des bibliothèques référencées par la commande de compilation. Maven aurait ainsi identifié notre bogue immédiatement.

Une arme à double tranchant

La facilité avec laquelle Maven permet de marier les bibliothèques, gérant dépendances et conflits, nous retire une (autre) sacrée épine du pied. Nous pouvons ainsi nous focaliser sur le développement du logiciel sans être freinés par d’ennuyeux problèmes techniques liés aux bibliothèques.

Notre application de gestion de liste de courses s’étoffe donc rapidement. Elle contient désormais des frameworks de toutes sortes comme Spring, Hibernate, Apache CXF ou Wicket pour prendre en charge les différents aspects de notre architecture. Maven construit pour nous l’archive web WAR de l’application que nous pouvons déployer sur notre serveur de test.

Un coup d’œil au répertoire WEB-INF/lib de l’application web nous fait cependant déchanter : plus de quarante bibliothèques s’y trouvent (qui a demandé tout ça ?). Il y a, par exemple, la bibliothèque Avalon, un framework ancien que plus personne n’utilise. Plus grave, nous trouvons dans ce répertoire des bibliothèques redondantes, comme un commons-logging-1.0.4 et un commons-logging-api-1.1. Voilà qui est bien troublant. Maven se serait-il emmêlé les pinceaux dans ses dépendances ?

La réponse à nos interrogations est cependant simple : Maven n’est pas un magicien et il ne peut gérer les dépendances entre bibliothèques que grâce aux métadonnées qu’il extrait des fichiers POM de chacune. La qualité de ces informations est déterminante pour obtenir une gestion fine et sans accrocs des dépendances. Il arrive malheureusement qu’une bibliothèque déclare des dépendances qui ne sont pas indispensables à son fonctionnement, ou bien propose plusieurs variantes. Dans ce cas, Maven a bien du mal à s’y retrouver.

La bibliothèque commons-logging en est une bonne illustration. Il s’agit d’une bibliothèque qui sert de façade pour passer de manière transparente d’un outil de log à un autre, par exemple de log4j au mécanisme intégré dans Java à partir de la version 1.4, ou encore à logkit, un autre outil comparable.

Le fichier POM de commons-logging déclare donc des dépendances vers toutes les bibliothèques de log qu’il supporte. La déclaration Maven correcte devrait être :

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.12</version>

<optional>true</optional>

</dependency>

<dependency>

<groupId>logkit</groupId>

<artifactId>logkit</artifactId>

<version>1.0.1</version>

<optional>true</optional>

</dependency>

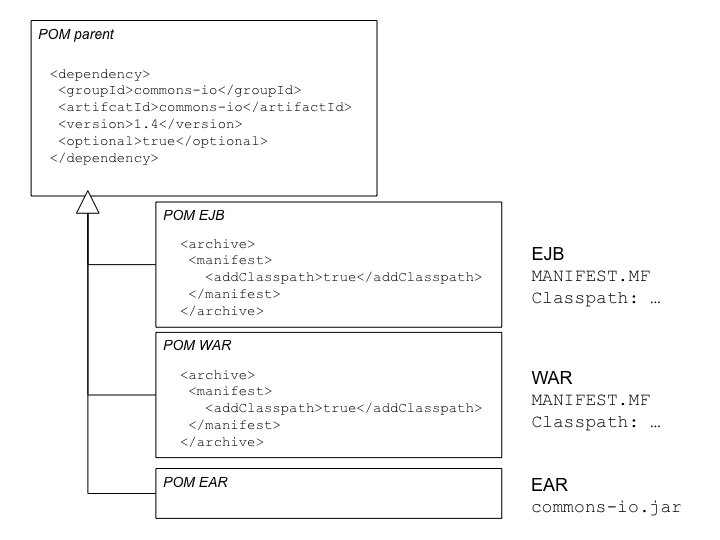

...L’élément <optional> permet de préciser la version de la bibliothèque pour laquelle le projet a été conçu, mais dont l’utilisation n’est pas nécessaire et ne correspond qu’à un cas particulier. Pour le malheur de nombreux utilisateurs, les développeurs de commons-logging ont cependant « oublié » de préciser ce caractère optionnel jusqu’à la version 1.1.1. C’est pour cette raison que nous retrouvons avalon-framework-4.1.3.jar dans nos bibliothèques.

|

La qualité des métadonnées a longtemps été un point faible de Maven, qui se corrige heureusement avec le temps et les nouvelles versions des bibliothèques incriminées. Les projets, même ceux qui n’utilisent pas Maven pour leurs propres besoins, sont aujourd’hui sensibilisés à ce besoin et prennent plus de soin à définir des dépendances fiables. |

Pour les versions anciennes cependant, une mise à jour n’est pas possible, car la politique de l’équipe qui gère le dépôt de bibliothèques de référence est de ne jamais modifier un POM qui a été publié, en raison du grand nombre de miroirs et de caches utilisé par la communauté : un fichier modifié signifierait qu’un miroir pourrait ne pas fournir la même version que le dépôt de référence, ce qui pourrait introduire des bogues insurmontables dans les projets. Sans compter que chaque utilisateur devrait manuellement purger son dépôt local pour forcer Maven à récupérer la version corrigée !

Maven possède heureusement une solution de contournement. Lorsque nous définissons une dépendance, nous pouvons exclure certains éléments de la transitivité. Ainsi, si nous voulons empêcher Spring – qui utilise commons-logging – d’introduire sur notre projet ce fameux JAR avalon-framework, nous pouvons écrire :

<dependency>

<groupId>org.springframework</groupId>

<artifactId>spring-beans</artifactId>

<version>2.5.6</version>

<exclusions>

<exclusion>

<groupId>avalon-framework</groupId>

<artifactId>avalon-framework</artifactId>

</exclusion>

</exclusions>

</dependency>Un autre problème que nous avons identifié est ce doublon commons-logging + commons-logging-api. Ce cas est plus subtil. Les développeurs de commons-logging proposent à leurs utilisateurs une série de classes qui masquent d’autres outils de log. Leur projet est donc séparé en une API et des adaptateurs vers chaque outil supporté. Pour éviter à certains d’utiliser par mégarde une classe d’un adaptateur et pas seulement celles de l’API, ils ont mis à disposition une archive JAR ne contenant que les classes utilisables par les développeurs : commons-logging-api.

Là où les choses se corsent, c’est que ces mêmes classes se retrouvent dans le commons-logging classique, et Maven n’est pas en mesure de le deviner. Aussi, de son point de vue, il s’agit de deux dépendances indépendantes pour lesquelles aucune règle de conflit ne peut s’appliquer.

Il n’existe malheureusement aucune solution miracle pour indiquer qu’une bibliothèque donnée est en réalité un sous-ensemble d’une autre, et pour gérer des conflits de version entre elles. Une gestion propre du développement de la bibliothèque aurait dû aboutir à la séparation de commons-logging-api et d’un second artefact complémentaire, mais pas redondant. À vouloir répondre aux demandes contradictoires des utilisateurs (un seul JAR avec tout le nécessaire, des JAR focalisés sur un aspect donné…) le projet perd en cohésion et les utilisateurs rencontrent finalement des difficultés qu’on aurait dû leur épargner.

Nous avons vu que les <exclusions> permettent de corriger ces erreurs de métadonnées. Reste à faire le tri dans nos dépendances pour trouver ces erreurs. Dans notre cas, nous voulons conserver commons-logging et exclure commons-logging-api, mais aucune solution automatique n’est possible.

L’analyse des dépendances

Avec le nombre de frameworks que nous avons intégrés à l’application, il devient difficile de savoir lequel introduit quelle dépendance. Même si les exclusions peuvent permettre de corriger le tir, encore faut-il savoir sur quelles dépendances les déclarer.

Maven propose un outillage complet pour analyser nos dépendances, via les plugins dependency et project-info-reports.

La commande mvn dependency:list permet d’établir la liste des

dépendances du projet, soit l’équivalent de notre répertoire

WEB-INF/lib. Elle sera utile pour vérifier l’impact de nos exclusions au

fur et à mesure que nous les déclarerons.

La commande project-info-reports:dependencies est analogue à la précédente mais elle génère un fichier HTML contenant la liste des dépendances.

Plus intéressante, mvn dependency:tree trace un arbre, où chaque branche

est une dépendance qui introduit par transitivité d’autres dépendances.

[INFO] [dependency:tree] [INFO] fr.noubliepaslalistedescourses:noubliepaslalistedescourses:war:1.0.0-SNAPSHOT [INFO] +- org.apache.cxf:cxf-rt-frontend-jaxws:jar:2.1.4:compile [INFO] | +- org.apache.geronimo.specs:geronimo-jaxws_2.1_spec:jar:1.0:compile [INFO] | +- org.apache.geronimo.specs:geronimo-ws-metadata_2.0_spec:jar:1.1.2:compile [INFO] | +- asm:asm:jar:2.2.3:compile [INFO] | +- org.apache.cxf:cxf-rt-bindings-xml:jar:2.1.4:compile [INFO] | +- org.apache.cxf:cxf-rt-frontend-simple:jar:2.1.4:compile [INFO] | +- org.apache.cxf:cxf-rt-ws-addr:jar:2.1.4:compile [INFO] | +- javax.xml.soap:saaj-api:jar:1.3:compile [INFO] | \- com.sun.xml.messaging.saaj:saaj-impl:jar:1.3.2:compile [INFO] | \- javax.xml.ws:jaxws-api:jar:2.1:compile [INFO] | +- javax.annotation:jsr250-api:jar:1.0:compile [INFO] | \- javax.jws:jsr181-api:jar:1.0-MR1:compile [INFO] +- org.springframework:spring-aspects:jar:2.5.6:compile [INFO] | \- org.aspectj:aspectjweaver:jar:1.6.2:compile [INFO] +- org.hibernate:hibernate-annotations:jar:3.4.0.GA:compile [INFO] | \- org.hibernate:ejb3-persistence:jar:1.0.2.GA:compile ...

L’analyse de cet arbre permet d’identifier les bibliothèques qui font appel à commons-logging-api et d’exclure cet intrus de notre projet.

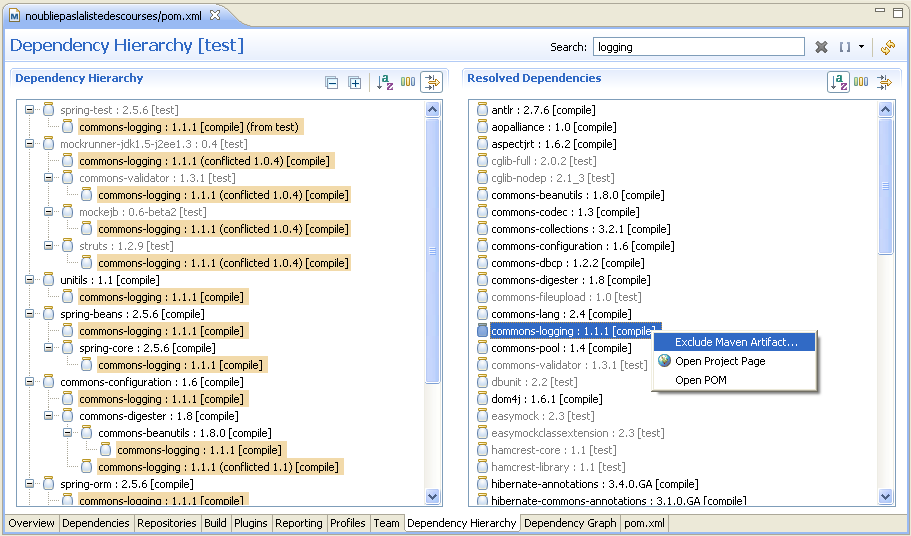

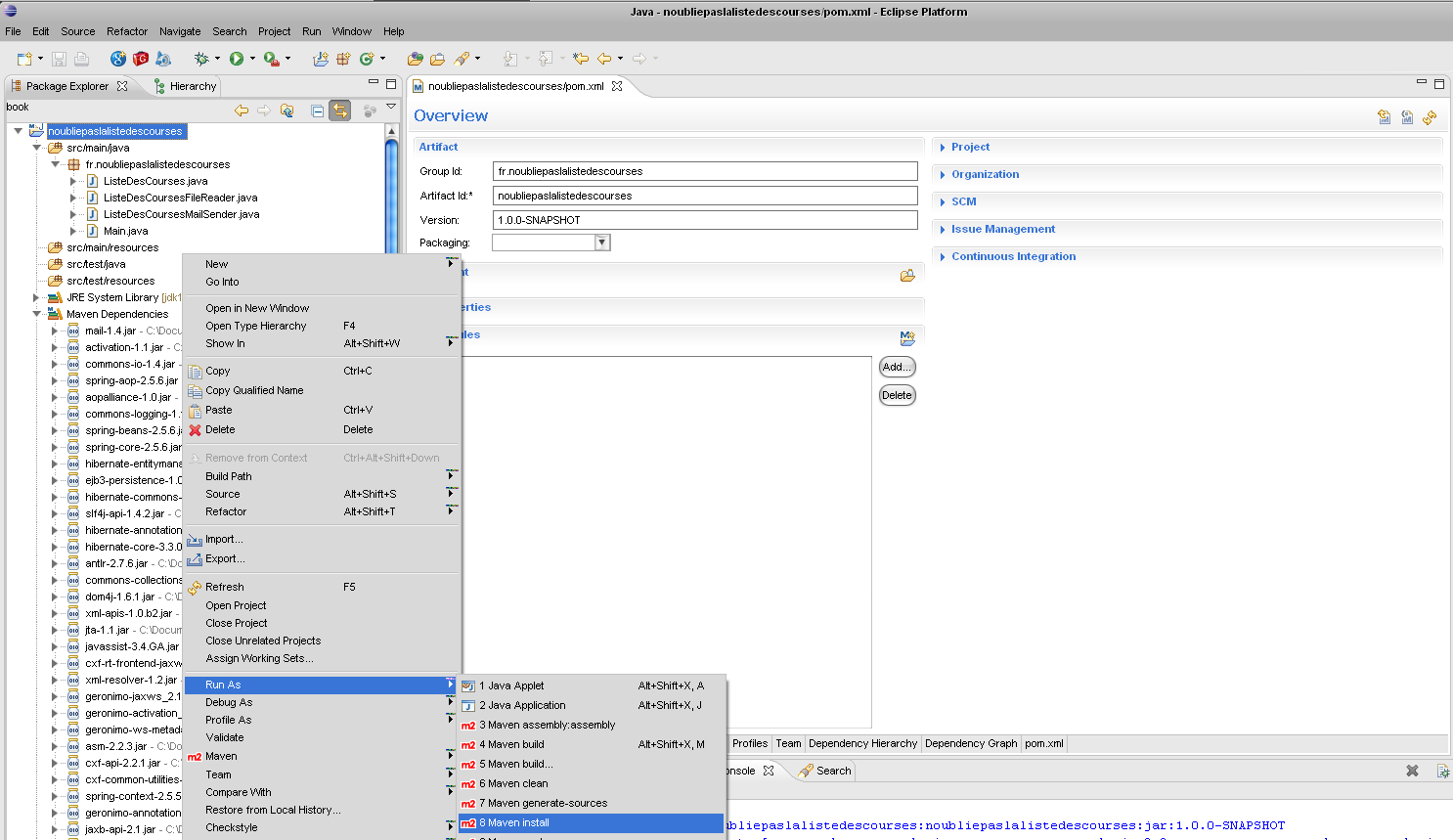

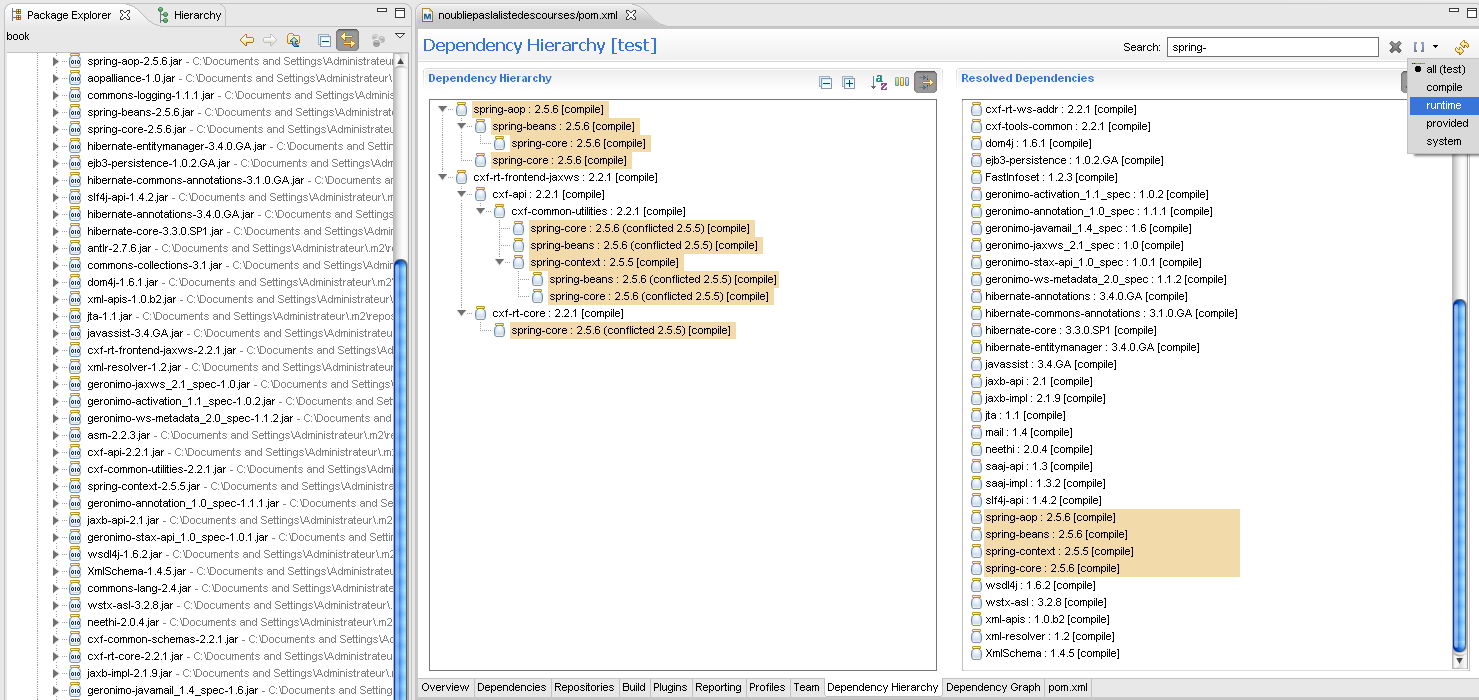

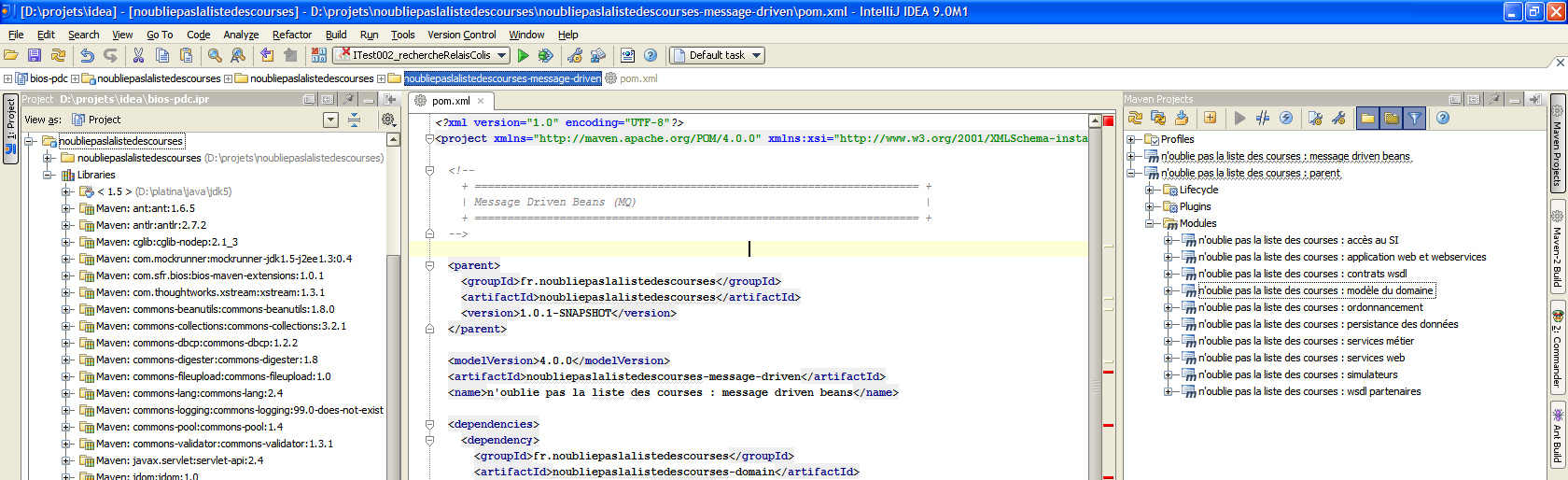

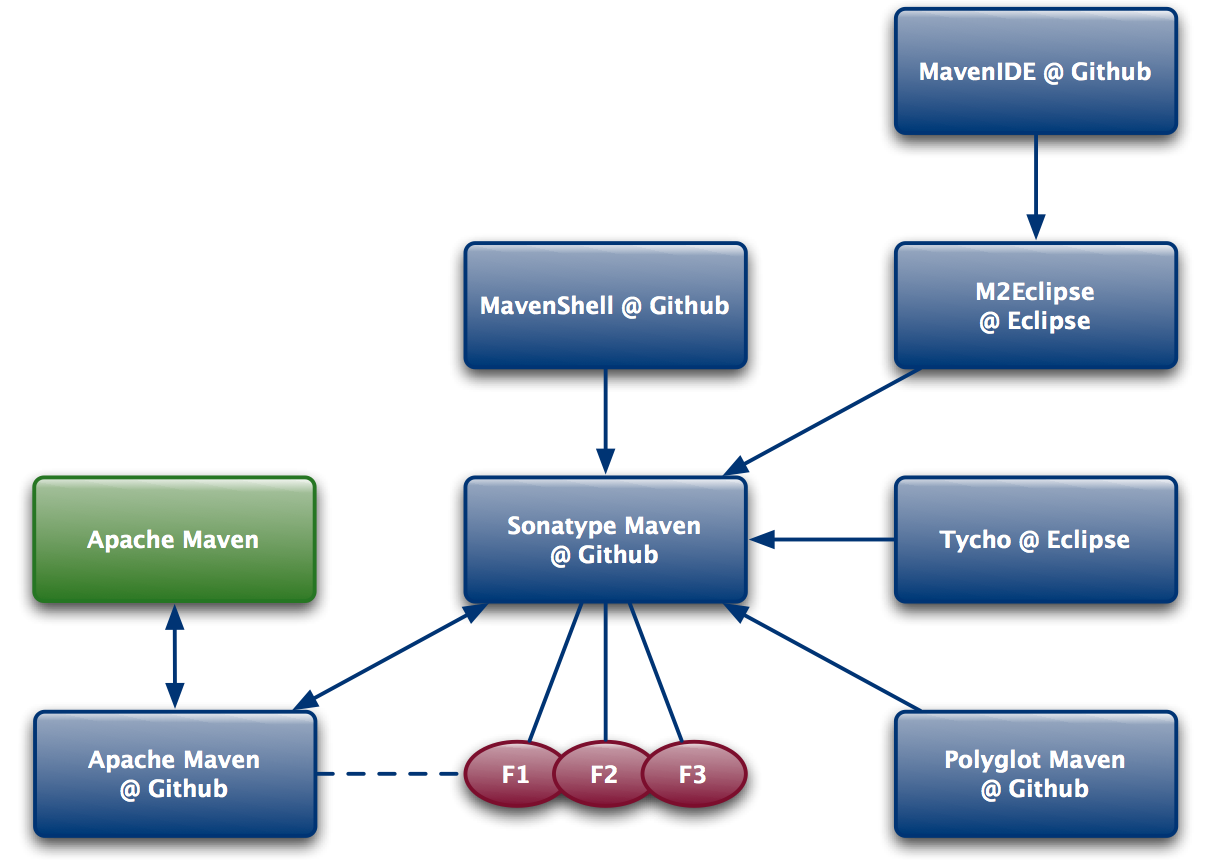

Ces commandes bien pratiques restent assez spartiates, cantonnées dans la console. L’intégration de Maven dans les environnements de développement en offre une version nettement plus ergonomique. La Figure 02-03 présente le plugin Maven pour Eclipse (m2eclipse) et sa fenêtre d’analyse des dépendances. Si on sélectionne une dépendance dans la zone de droite, il nous indique tous les chemins de dépendance qui y mènent. Un simple clic permet de placer les exclusions qui s’imposent sans éditer manuellement le fichier POM.

Plugin Maven pour Eclipse.

Dépôts et dépendances

En rejoignant le projet, Emmanuel apporte dans sa musette bon nombre d’idées innovantes et de petites expériences amusantes à nous présenter. Entre autre, Emmanuel a testé un outil rigolo, une implémentation de JCR sur la base NoSQL Cassandra. Rien que l’assemblage que cela représente attise notre curiosité. Place à la démo !

Oups :

[INFO] ------------------------------------------------------------------------ [INFO] Building demo démo 1 [INFO] ------------------------------------------------------------------------ Downloading: http://repo1.maven.org/maven2/org/geeks/jcr-on-cassandra/1.8.0.10/jcr-on-cassandra-1.8.0.10.pom [WARNING] The POM for org.geeks:jcr-on-cassandra:jar:1.8.0.10 is missing, no dependency information available Downloading: http://repo1.maven.org/maven2/org/geeks/jcr-on-cassandra/1.8.0.10/jcr-on-cassandra-1.8.0.10.jar [INFO] ------------------------------------------------------------------------ [INFO] BUILD FAILURE [INFO] ------------------------------------------------------------------------

« WTF ? » comme on dit outre-Atlantique [8], ce que nous ne traduirons pas ici par respect pour nos lecteurs et la qualité de ce récit. Maven s’acharne – et échoue – à télécharge la bibliothèque jcr-on-cassandra :

[ERROR] Failed to execute goal on project demo: + Could not resolve dependencies for project demo:demo:jar:1: Could not find artifact org.geeks:jcr-on-cassandra:jar:1.8.0.10 in central

Emmanuel vérifie trois fois, la bibliothèque jcr-on-cassandra dont il veut nous montrer le potentiel est bien dans son dépôt local, pourtant – rien à faire – Maven fait la sourde oreille. Il est temps de faire appel à nos experts…

LES EXPERTS

Arnaud vient faire un prélèvement ADN dans le projet d’exemple qui a inspiré Emmanuel pour sa démo. Il en extrait une déclaration de dépôt http://repository.geek.org/ qu’il place sous scellés pour la suite de l’enquête.

<repository>

<id>geeks.org</id>

<url>http://repository.geeks.org</url>

<repository>

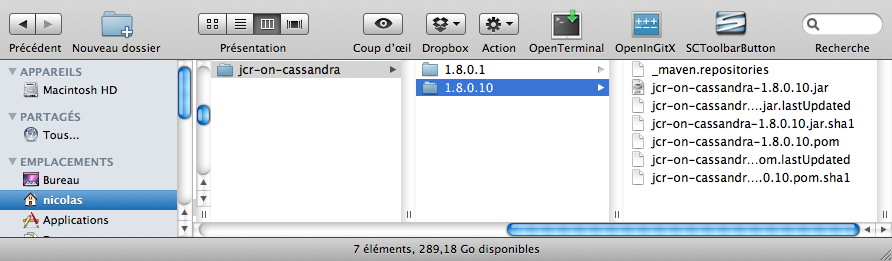

Nicolas fouille le dépôt local d’Emmanuel à la recherche d’indices. Sous sa lampe à ultraviolet, le Luminol met en évidence des traces de métadonnées. Un échantillon est prélevé pour analyse.

Contenu du dépôt local pour la bibliothèque jcr-on-cassandra.

Au labo, Vincent analyse nos indices. Le fichier maven.repositories attire particulièrement son attention :

#NOTE: This is an internal implementation file, its format can be changed without prior notice. #Mon Mar 07 16:16:01 CET 2011 jcr-on-cassandra-1.8.0.10.jar>geek.org= jcr-on-cassandra-1.8.0.10.pom>geek.org=

Le compte-rendu de nos experts fournit l’explication.

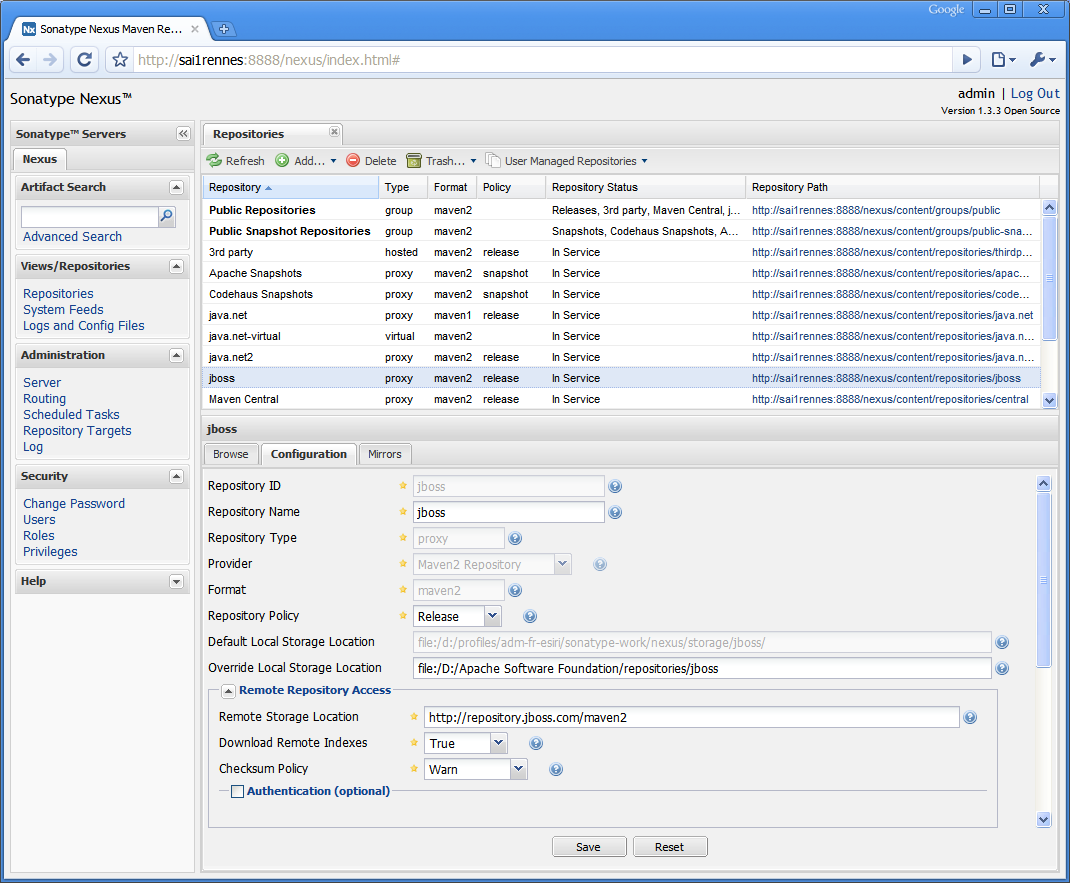

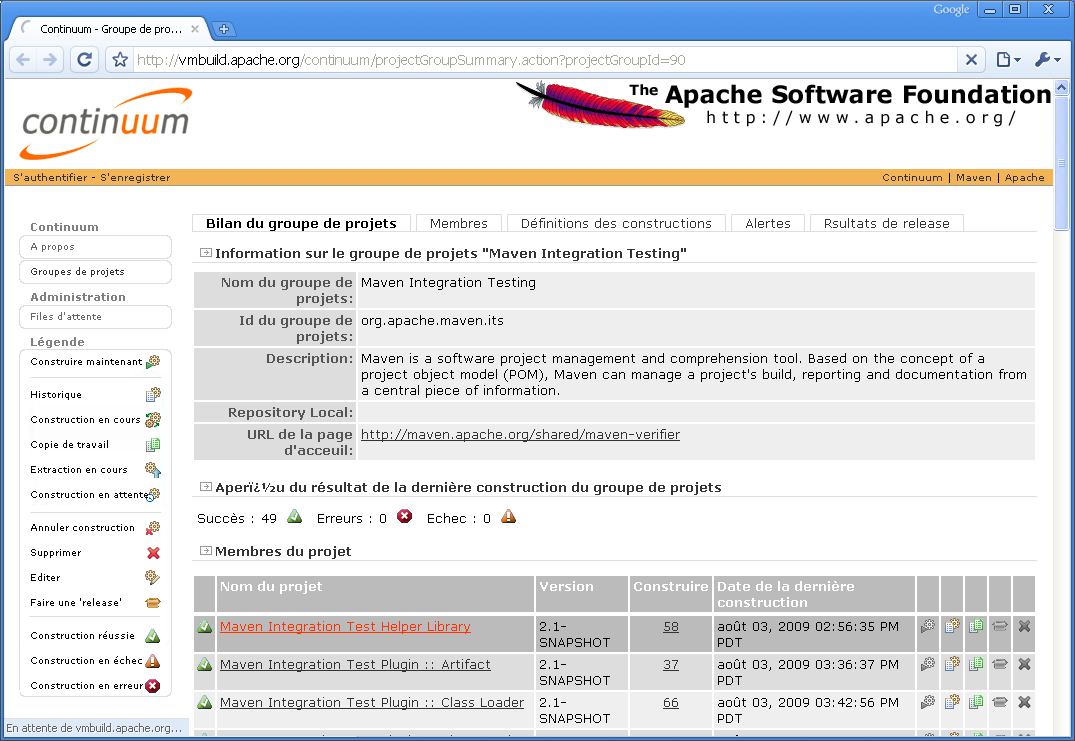

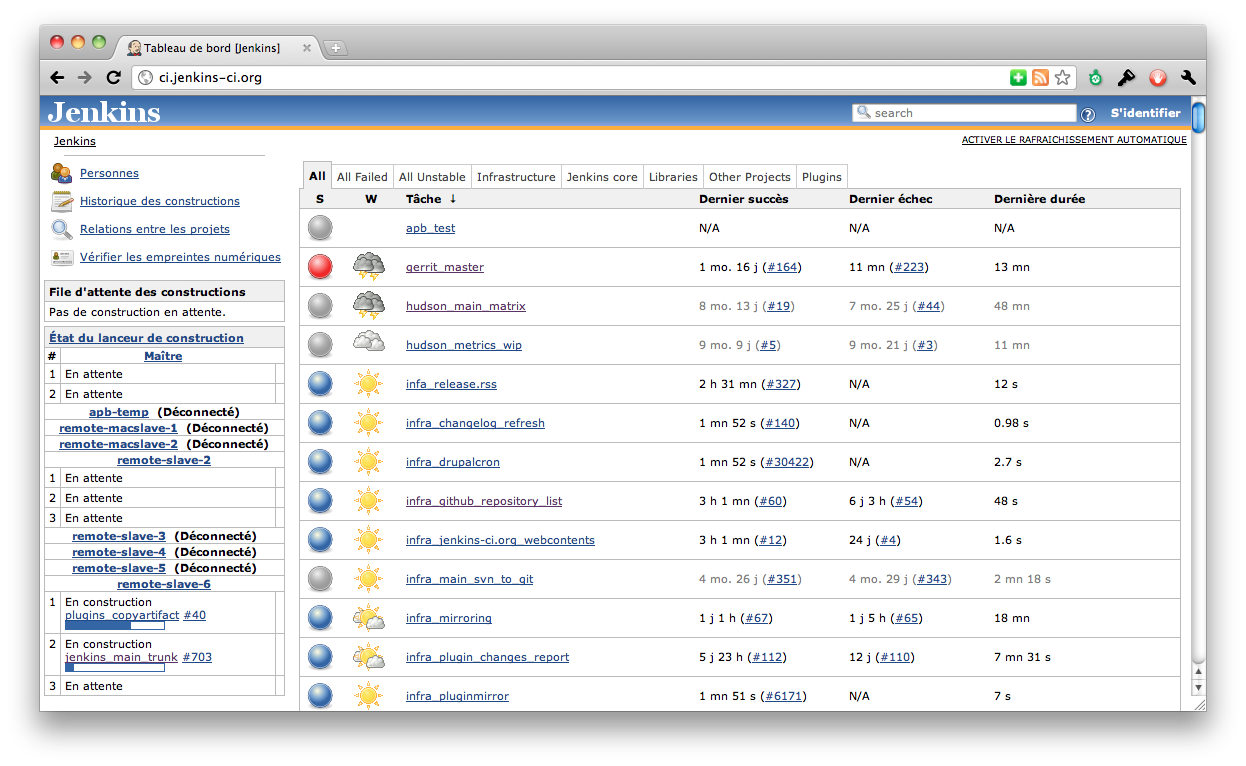

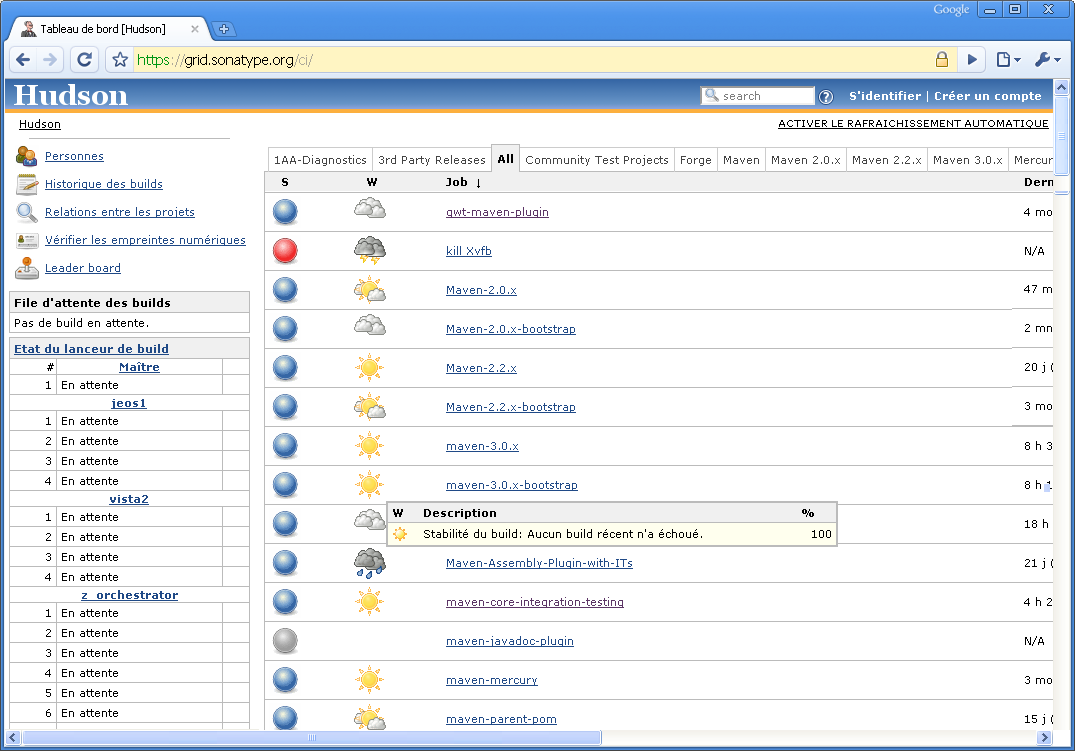

Dépôts et dépendances

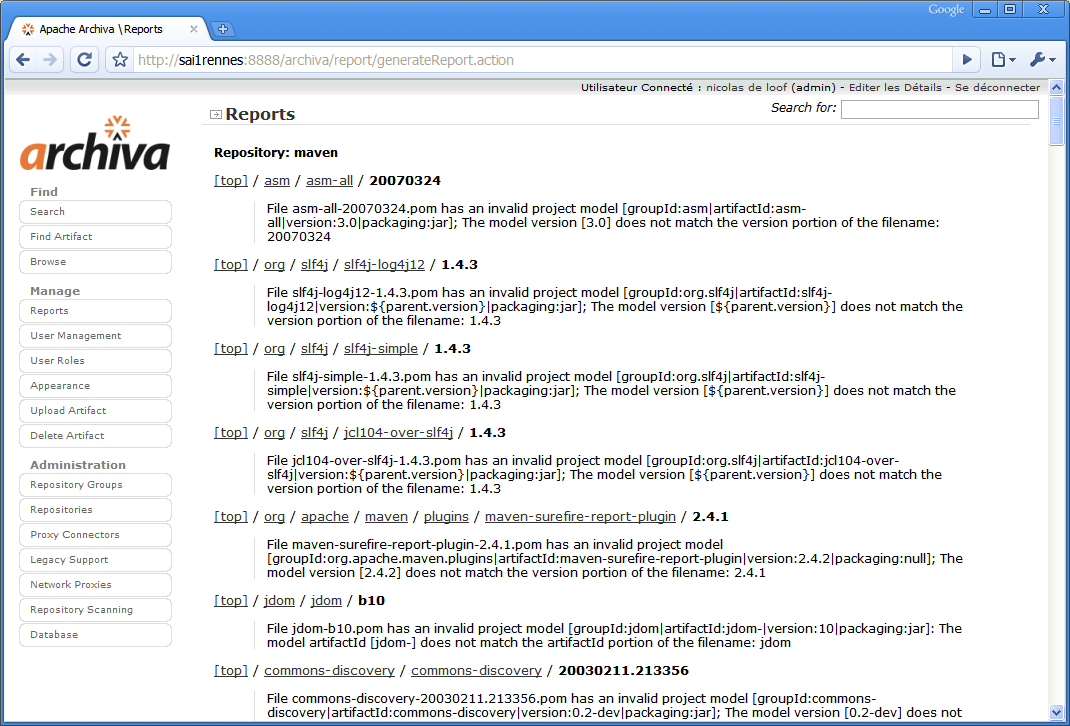

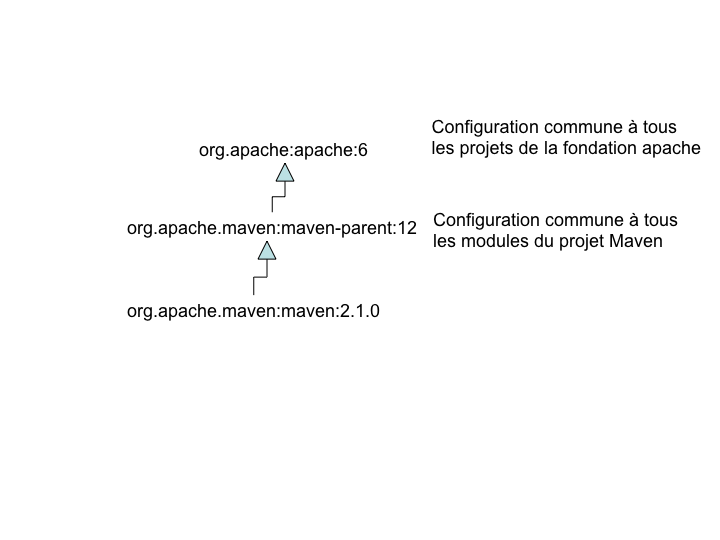

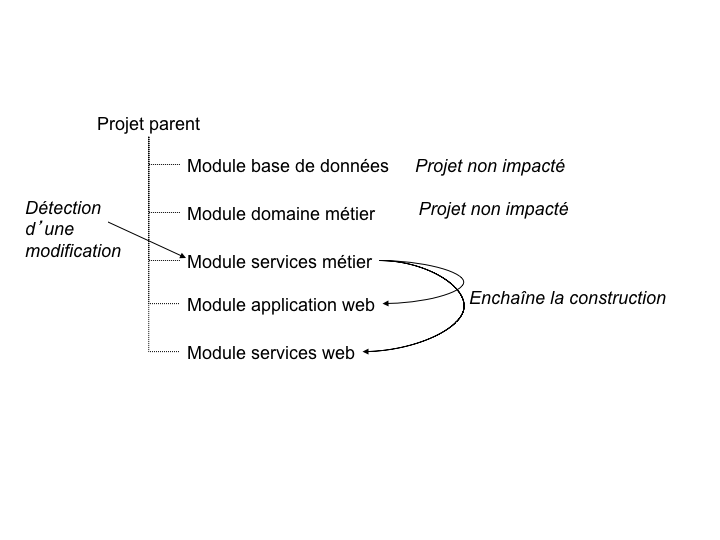

Maven utilise par défaut un dépôt nommé central, qui héberge un vaste choix de bibliothèques Open Source. Pour une grande majorité de développements, ce dépôt sera suffisant pour nous fournir toutes les dépendances nécessaires. Il arrive cependant régulièrement qu’un projet ne contribue pas à ce dépôt et préfère héberger son propre dépôt interne, souvent en prétextant plus de simplicité de mise en œuvre ou une meilleure maîtrise de ses infrastructures.